日誌主要包括系統日誌、應用程序日誌和安全日誌。系統運維和開發人員可以通過日誌瞭解服務器軟硬件信息、檢查配置過程中的錯誤及錯誤發生的原因。經常分析日誌可以瞭解服務器的負荷,性能安全性,從而及時採取措施糾正錯誤。

通常,日誌被分散的儲存不同的設備上。如果你管理數十上百臺服務器,你還在使用依次登錄每臺機器的傳統方法查閱日誌。這樣是不是感覺很繁瑣和效率低下。當務之急我們使用集中化的日誌管理,例如:開源的syslog,將所有服務器上的日誌收集彙總。

集中化管理日誌後,日誌的統計和檢索又成爲一件比較麻煩的事情,一般我們使用grep、awk和wc等Linux命令能實現檢索和統計,但是對於要求更高的查詢、排序和統計等要求和龐大的機器數量依然使用這樣的方法難免有點力不從心。

開源實時日誌分析ELK平臺能夠完美的解決我們上述的問題,ELK由ElasticSearch、Logstash和Kiabana三個開源工具組成。官方網站:https://www.elastic.co

Elasticsearch 是個開源分佈式搜索引擎,它的特點有:分佈式,零配置,自動發現,索引自動分片,索引副本機制,restful風格接口,多數據源,自動搜索負載等。

Logstash 是一個完全開源的工具,他可以對你的日誌進行收集、分析,並將其存儲供以後使用(如,搜索)

kibana 也是一個開源和免費的工具,他Kibana可以爲 Logstash 和 ElasticSearch 提供的日誌分析友好的 Web 界面,可以幫助您彙總、分析和搜索重要數據日誌。

開源實時日誌分析ELK平臺部署流程:

1、安裝Logstash依賴包JDK

Logstash的運行依賴於Java運行環境, Logstash 1.5以上版本不低於java 7推薦使用最新版本的Java。由於我們只是運行Java程序,而不是開發,下載JRE即可。首先,在Oracle官方下載新版jre,下 載地址:http://www.oracle.com/technetwork/java/javase/downloads/jre8-downloads-2133155.html

# tar -zxf jdk-8u45-linux-x64.tar.gz -C /usr/local/ 設置環境變量 /etc/profile,添加一下代碼 export JAVA_HOME=/usr/local/jdk1.8.0_45 export PATH=$PATH:$JAVA_HOME/bin exportCLASSPATH=.:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib/dt.jar:$CLASSPATH # source /etc/profile 測試是否安裝成功 # java -version

2、安裝Logstash (日誌收集、分析,並將其存儲供以後使用)

下載並安裝Logstash,安裝logstash只需將它解壓的對應目錄即可,例如:/usr/local下:

下載地址https://www.elastic.co/downloads/logstash

# https://download.elastic.co/logstash/logstash/logstash-2.4.0.tar.gz # tar –zxf logstash-2.4.0.tar.gz -C /usr/local/

安裝完成後運行如下命令啓動logstash:

普通方式啓動

# logstash -e 'input { stdin { } } output { stdout {} }'

Settings: Default pipeline workers: 2

Pipeline main started

等待輸入: hello world

2016-09-06T06:22:50.326Z localhost.localdomain hello world

我們可以看到,我們輸入什麼內容logstash按照某種格式輸出,其中-e參數參數允許Logstash直接通過命令行接受設置。這點尤其快速的幫助我們反覆的測試配置是否正確而不用寫配置文件。使用CTRL-C命令可以退出之前運行的Logstash。使用-e參數在命令行中指定配置是很常用的方式,不過如果需要配置更多設置則需要很長的內容。

這種情況,我們首先創建一個簡單的配置文件,並且指定logstash使用這個配置文件。

例如:在logstash安裝目錄下創建一個“基本配置”測試文件logstash-test.conf,文件內容如下:

# cat logstash-test.conf

input { stdin { }}

output { stdout { codec=> rubydebug }}Logstash使用input和output定義收集日誌時的輸入和輸出的相關配置,本例中input定義了一個叫"stdin"的input,output定義一個叫"stdout"的output。

無論我們輸入什麼字符,Logstash都會按照某種格式來返回我們輸入的字符,其中output被定義爲"stdout"並使用了codec參數來指定logstash輸出格式。

開啓debug模式啓動

使用logstash的-f參數來讀取配置文件然後啓動,執行如下開始進行測試:(debug方式啓動)

# /usr/local/logstash-2.3.4/bin/logstash agent -f /usr/local/logstash-2.3.4/conf/logstash-test.conf

Logstash startup completed

Tue Jul 14 18:07:07 EDT 2015 hello World #該行是執行echo “`date`hello World” 後輸出的結果,直接粘貼到該位置,然後會輸出下面結果

{

"message" => "Tue Sep 6 14:25:52 CST 2016 hello world",

"@version" => "1",

"@timestamp" => "2016-09-06T06:26:31.270Z",

"host" => "localhost.localdomain"

}2.1、logstash輸出信息到redis數據庫中

剛纔我們是將信息直接顯示在屏幕上了,現在我們將logstash的輸出信息保存到redis數據庫中,

logstash輸出信息存儲到redis數據庫中,redis其實就充當一個消息隊列,並不作爲存儲,等待elasticsearch的消費

前提是本地安裝有redis數據庫,那麼下一步我們就是安裝redis數據庫.

# cat /usr/local/logstash-2.3.4/conf/logstash_index_redis.conf 將信息存儲到redis

input { stdin { } }

output {

stdout { codec => rubydebug }

redis {

host => '10.2.8.45'

port => 6379

data_type => 'list'

key => 'logstash'

}

}logstash的默認端口號9301

# netstat -tnlp |grep 9301

服務端的redis收集日誌配置文件

# cat logstash_index_redis.conf 從redis讀取信息,並且發送到elasticsearch

input {

redis {

host => "10.2.8.45"

port => 6379

data_type => "list"

key => "logstash"

codec => "json"

}

}

output {

stdout { codec => rubydebug }

elasticsearch { hosts => "10.2.8.45" }

}客戶端將收集的信息存儲到redis的配置文件

# cat logstash_agent.conf

input {

file {

path => [ "/var/log/messages", "/var/log/*.log" ]

type => "system"

start_position => beginning

}

}

output {

stdout { codec => rubydebug }

redis {

host => "10.2.8.45"

port => 6379

data_type => "list"

key => "logstash"

}

# elasticsearch { hosts => "10.2.8.45" }

}3、安裝Elasticsearch

下載地址 https://www.elastic.co/downloads/elasticsearch

建立啓動elasticsearch的普通用戶(默認情況下不能使root用戶啓動elasticsearch)

# groupadd elk # useradd elasticsearch -g elk

安裝

# tar zxvf https://download.elastic.co/elasticsearch/release/org/elasticsearch/distribution/tar/elasticsearch/2.4.0/elasticsearch-2.4.0.tar.gz -C /usr/local/ # 修改配置文件 /usr/local/elasticsearch-2.3.5/config/elasticsearch.yml network.host: 10.2.8.45 # 端口綁定ip地址 http.port: 9200

啓動(注意! 默認是不能使用root用戶啓動,要使用普通用戶)

# su - elasticsearch # nohup /usr/local/elasticsearch-2.3.5/bin/elasticsearch > nohup & # netstat -anp |grep :9200 # curl http://localhost:9200 #查看當前elastcisearch狀態

接下來我們在logstash安裝目錄下創建一個用於測試logstash使用elasticsearch作爲logstash的後端的測試文件logstash_elasticsearch.conf,

該文件中定義了stdout和elasticsearch作爲output,這樣的“多重輸出”即保證輸出結果顯示到屏幕上,同時也輸出到elastisearch中。

# cat /user/local/logstash-2.3.4/conf.d/logstash_elasticsearch.conf

input { stdin { } } # 手動輸入內容

output {

elasticsearch {hosts => "localhost" } # 輸出到elasticsearch

stdout { codec=> rubydebug } # 輸出到屏幕上

}執行如下命令

# logstash agent -f /user/local/logstash-2.3.4/conf.d/logstash_elasticsearch.conf

hello logstash # 輸入

輸出如下結果

{

"message" => "hello logstash",

"@version" => "1",

"@timestamp" => "2016-09-06T06:49:39.654Z",

"host" => "localhost.localdomain"

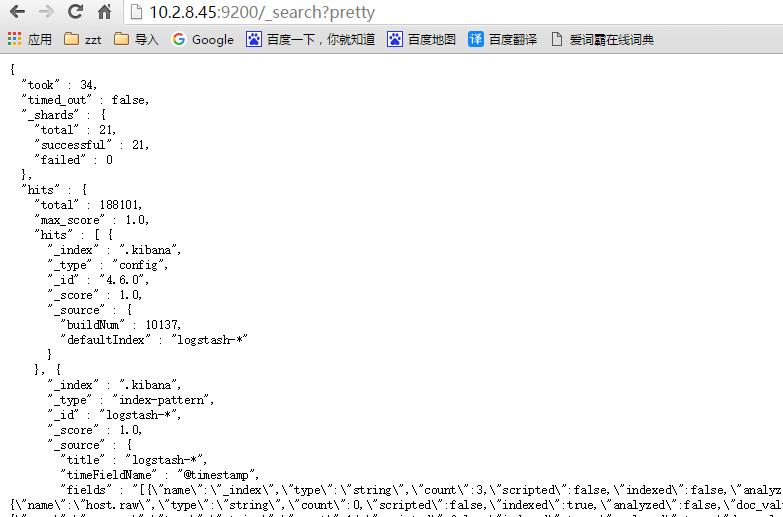

}我們可以使用curl命令發送請求來查看ES是否接收到了數據:

# curl http://localhost:9200/_search?pretty

至此,已經成功利用Elasticsearch和Logstash來收集日誌數據了

3.1、安裝elasticsearch插件

Elasticsearch-kopf插件可以查詢Elasticsearch中的數據,安裝elasticsearch-kopf,只要在你安裝Elasticsearch的目錄中執行以下命令即可:

# cd /usr/local/elasticsearch-2.3.5/bin # ./plugin install lmenezes/elasticsearch-kopf

執行插件安裝後會提示失敗,很有可能是網絡等情況.. 若下載失敗可以手動下載該軟件,不通過插件安裝命令... # cd /usr/local/elasticsearch-2.3.5/plugins # wget https://github.com/lmenezes/elasticsearch-kopf/archive/master.zip # unzip master.zip # mv elasticsearch-kopf-master kopf 安裝完成後在plugins目錄下可以看到 kopf 目錄 瀏覽器訪問kopf頁面訪問elasticsearch保存的數據 http://10.2.8.45:9200/_plugin/kopf/

4、安裝Kibana

# wget https://download.elastic.co/kibana/kibana/kibana-4.6.0-linux-x86_64.tar.gz 修改配置文件 /usr/local/kibana-4.6.0-linux-x86_64/config/kibana.yml elasticsearch.url: " 啓動(後臺啓動) # nohup /usr/local/kibana-4.6.0-linux-x86_64/bin/kibana > nohup.out & 默認端口 5601 # netstat -tnlp |grep 5601

ELK默認端口 logstash 9301 elasticsearch 9200 9300 kibana 5601

瀏覽器訪問 http://10.2.8.45:5601

頁面錯誤提示:

1、This version of Kibana requires Elasticsearch ^2.4.0 on all nodes. I found the following incompatible nodes in your cluster: Elasticsearch v2.3.5 @ 10.2.8.45:9200 (10.2.8.45) 說明是Kibana版本和elasticsearch的版本不匹配,查看官網,安裝匹配版本 2、unable to fetch mapping. 這就說明logstash沒有把日誌寫入到elasticsearch。 檢查logstash與elasticsearch之間的通訊是否有問題,一般問題就在這。修改完成後重啓應用

然後點擊“Discover”,可以搜索和瀏覽Elasticsearch中的數據,默認搜索的是最近15分鐘的數據。可以自定義選擇時間。

到此,說明你的ELK平臺安裝部署完成。

客戶端安裝

客戶端只需要安裝logstash即可,安裝方法如上1和2(必須要安裝jdk)

然後在/usr/local/logstash-2.3.4/conf/添加logstash_agent.conf配置文件(可按需修改)

# cat logstash_agent.conf

input {

file {

path => [ "/var/log/messages", "/var/log/*.log" ] # 要收集的日誌文件

type => "system" # 自定義類型,會在kibana中顯示

start_position => beginning

}

}

output {

stdout { codec => rubydebug }

redis {

host => "10.2.8.45"

port => 6379

data_type => "list"

key => "logstash"

}

# elasticsearch { hosts => "10.2.8.45" }

}

後臺運行

# nohup /usr/local/logstash-2.3.4/bin/logstash agent -f /usr/local/logstash-2.3.4/conf/logstash_agent.conf > /usr/local/logstash-2.3.4/logstash.log 2>&1 &

查看進程

# ps -ef|grep java