近两年“软件定义”已经被业界很多商业公司与技术咖所青睐;“软件定义一切”具有技术改革与实际价值,在虚拟化管理平台软件定义一直性体现在三大方面:软件定义计算(SDC),软件定义网络(SDN),软件定义存储(SDS);

软件定义存储(SDS)是众多中小企业在IT架构基础建设中比较重要的一项,存储是每个程序与应用必不可少的组成部分,存储TCO也是大家所关注的重点,权衡在性能(Performance)、容量(Capability)、TCO(总拥有成本)三方面,根据这三方面考虑Ceph分布式存储特色具有很好的实际使用价值与灵活的结构,让中小企业在RBD、OD等存储方式有了更好的选择;Ceph具有开源与社区活跃优势,同时与主流IaaS架构Openstack结合密切等,Ceph生态系统也是有很多IT公司协同开发,如今用户群体包含国内外知名厂商,最新版本更新到2016.3 Jewel.

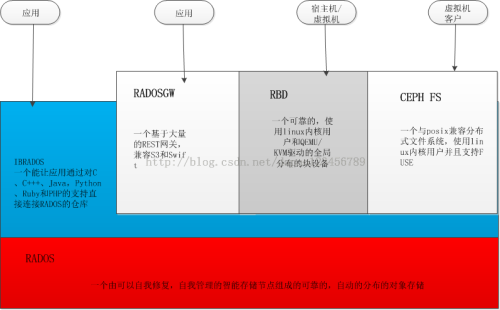

Ceph基础架构

Ceph提供RBD、FS等存储方式支持,Ceph分布式针对于大规模PB级环境部署,技术特性体现在Cluster可靠性与扩展行,Data Replace、Interface统一性;Ceph去中心的设计思想可让计算能力得到了充分发挥,Crush算法可保证各OSD与Monitor Node提供HA ENV;对于Openstack架构的后端存储,侧重在Ceph RBD存储,RBD是基于LIBRADOS之上,通过QEMU/KVM Attach至VM上.

OpenStack架构后端存储核心在于VM、Volume、Images三方面,Ceph RBD可无缝支持这三项存储,经过几个项目的实践,Ceph RBD存储方式稳定性还是非常好,Ceph自身Journal优化特性可提高硬盘存储读写性能;利用Ceph在设计OpenStack后端存储解决方案时,建议合理规划硬件资源与评估存储需求,这样才能在PCT三方Balance;

根据公司业务存储场景,可提供High Performance Pools与Common Pools,根据Openstack配置与对接方式,将Compute Pools进行整合,进行对应的存储Pools对接;

Ceph存储自身规划

1、硬件选型:CPU、Mem、Disk按照OSD Process(2C、1G)与Monitor(2C、2G)合理规划

2、版本选型以及系统文件:Ceph目前稳定版本Jewel V10.0.0(社区推荐),系统文件格式Ext4

3、网络:建议生产环境采用10G网络,Ceph Public Net与Client Net进行物理隔离,提供稳定与数据高保证性;可通过网络调优引入巨型帧来提高网络传输

4、硬盘:Journal盘与Data盘建议1:6,匹配方式SSD(J)-SAS,PCIE(J)-SSD

5、Ceph调优:硬件层面(BIOS、磁盘IOPS)、System层面(Cgroup、Kernel)、网络层面(巨型帧、硬件加速)、Ceph(合理设置PG-PGS、副本数、对接存储位置等)

6、扩展:尽量减少纵向扩展、根据Crush Map进行Object物理Host存储,随着业务发展及时进行横向扩展

7、监控:对OSD Perf项进行监控,防止主副节点影响存储速度;对集群Health网络、硬件状态等实时监控、及时处理故障问题

8、测试:初次搭建进行全面IOPS与网络吞吐量测试、以及故障通过测试排除问题

Ceph效率提升:增加并行度与降低服务时间

Ceph实际生产环境中,可支持多类型存储,对象存储、文件存储、块存储等,Openstack匹配完美的则是Ceph RBD方式存储,灵活地配置方式以及全面的driver支持,Ceph稳定与高可用灵活架构以及Crush算法让Ceph分布式存储解决方案成为Openstack最重要的存储伙伴;随着Openstack高速发展,Ceph也是以6个月一个新版本进行迭代,开源虚拟化以及存储虚拟化是未来最具有商业价值与研究的热点.