說明:由於圖片過於多沒有一一截圖,還望大家見諒。 ![j_0017.gif]()

3、集羣的 Oracle Grid Infrastructure 的安裝:

所需的oracle軟件如下:

o 適用於 Linux 的 Oracle Database 11g 第 2 版 Grid Infrastructure (11.2.0.1.0)

o 適用於 Linux 的 Oracle Database 11g 第 2 版 (11.2.0.1.0)

o Oracle Database 11g 第 2 版 Examples(可選)

安裝用於 Linux 的 cvuqdisk 程序包

在兩個 Oracle RAC 節點上安裝操作系統程序包 cvuqdisk。如果沒有 cvuqdisk,集羣驗證實用程序就無法發現共享磁盤,當運行(手動運行或在 Oracle Grid Infrastructure 安裝結束時自動運行)集羣驗證實用程序時,您會收到這樣的錯誤消息:“Package cvuqdisk not installed”。使用適用於您的硬件體系結構(例如,x86_64 或 i386)的 cvuqdisk RPM。

cvuqdisk RPM 包含在 Oracle Grid Infrastructure 安裝介質上的 rpm 目錄中。

3.1 安裝cvuqdisk

設置環境變量 CVUQDISK_GRP,使其指向作爲 cvuqdisk 的所有者所在的組(本文爲 oinstall):

[root@OceanI ~]# CVUQDISK_GRP=oinstall; export CVUQDISK_GRP [root@OceanV ~]# CVUQDISK_GRP=oinstall; export CVUQDISK_GRP

在保存 cvuqdisk RPM 的目錄中,使用以下命令在兩個 Oracle RAC 節點上安裝 cvuqdisk 程序包:

[root@OceanI rpm]# pwd /data/grid/rpm [root@OceanI rpm]# rpm -ivh cvuqdisk-1.0.7-1.rpm [root@OceanV rpm]# rpm -ivh cvuqdisk-1.0.7-1.rpm

使用 CVU 驗證是否滿足 Oracle 集羣件要求

記住要作爲 grid 用戶在將要執行 Oracle 安裝的節點 (racnode1) 上運行。此外,必須爲 grid 用戶配置通過用戶等效性實現的 SSH 連通性。

在grid軟件目錄裏運行以下命令:

[root@OceanI grid]#$./runcluvfy.sh stage -pre crsinst -n OceanI,OceanV -fixup -verbose

使用 CVU 驗證硬件和操作系統設置

[root@OceanI grid]#./runcluvfy.sh stage -post hwos -n OceanI,OceanV -verbose

查看 CVU 報告。CVU 執行的所有其他檢查的結果報告應該爲“passed”,之後才能繼續進行 Oracle Grid Infrastructure 的安裝。

3.2、爲集羣安裝 Oracle Grid Infrastructure:

su - grid #./runInstaller

此處省略 N 張圖 ........

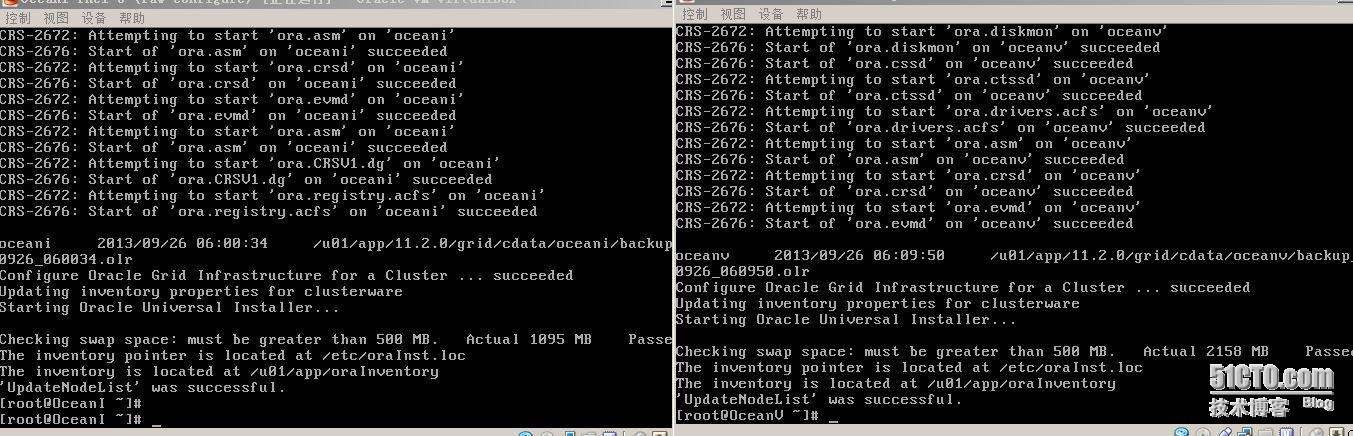

當彈出執行腳本的時候一定要先 local node 然後再remote node 切記不可一味圖塊

3.3、檢驗cluster安裝是否成功

1.檢查集羣中的結點狀態

2.檢查SCAN是否產生,是否能ping通

3.檢查所有服務的狀態

4.檢查ASM實例的狀態

4、安裝database soft & database

4.1、創建asm_group

su - grid asmca

4.2、使用oracle用戶調用圖形界面進行安裝Oracle Database

$./runInstaller

4.3、使用oracle用戶調用dbca創建數據庫

$dbca

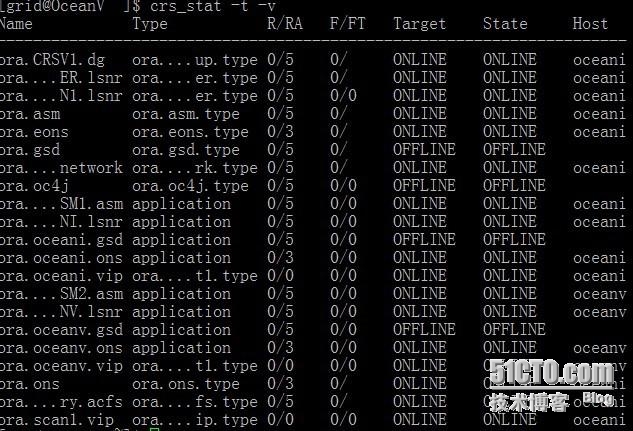

4.4、查看整個集羣狀態

#crs_stat -t

其它注意事項:

1.給votedisk和ocr創建ASM時,如果選擇normal模式,則需要3個ASM disk。

2.安裝Oracle Grid Infrastructure的ORACLE_HOME目錄與ORACLE_BASE目錄不能存在從屬關係;而安裝Oracle Database的ORACLE_HOME又必須在ORACLE_BASE目錄下。

5、部分錯誤整理:

錯誤1:

在第一個節點執行root.sh時報錯:

error while loading shared libraries:libcap.so.1:cannot open shared object file: No such file or directory

解決辦法:

確定libcap包已經安裝

rpm -q libcap

find / -name '*libcap*' -print

創建鏈接

ln -s /lib64/libcap.so.2.16 /lib64/libcap.so.1

刪掉root.sh的配置:

./roothas.pl -deconfig -verbose -force

再次運行root.sh即可。

錯誤2:

這個錯誤會在Redhat6.x/CentOS6.x上安裝Oracle11gR2 11.2.0.1 RAC時出現。

在第一個節點執行root.sh時報錯(各個節點都會出現這個問題):

Adding daemon to inittab

CRS-4124: Oracle High Availability Services startup failed.

CRS-4000: Command Start failed, or completed with errors.

解決辦法:(臨時)

在生成了文件/var/tmp/.oracle/npohasd文件後,使用root立即執行以下命令命令:

/bin/dd if=/var/tmp/.oracle/npohasd of=/dev/null bs=1024 count=1

如果懶得看npohasd有沒有生成,就用下面的命令讓它自動完成

watch -n 0.5 /bin/dd if=/var/tmp/.oracle/npohasd of=/dev/null bs=1024 count=1

錯誤3:

通過dbca方式, 在基於ASM存儲建庫時, 報以下錯誤:

ORA-12547: TNS:lost contact

原因:

In environment where listener home (including SCAN listener which resides in Grid Infrastructure/ASM home) and database home are owned by different OS user, ORA-12537 could happen when connecting through listener, when creating database through DBCA, or when installing database software and creating a database in runInstaller. Job Role Separation is a typical example as SCAN and local grid home listener is owned differently than database.

解決辦法:

檢查grid安裝的SCAN listener目錄和Oracle Database目錄的owner是不是一樣的。如果不一樣,改成一樣或將目錄設置爲770權限。