一、MySQL的複製原理以及流程

(1)複製基本原理流程

1. 主:binlog線程——記錄下所有改變了數據庫數據的語句,放進master上的binlog中;

2. 從:io線程——在使用start slave 之後,負責從master上拉取 binlog 內容,放進 自己的relay log中;

3. 從:sql執行線程——執行relay log中的語句;

(2)MySQL複製的線程有幾個及之間的關聯

MySQL 的複製是基於如下 3 個線程的交互( 多線程複製裏面應該是 4 類線程):

1. Master 上面的 binlog dump 線程,該線程負責將 master 的 binlog event 傳到slave;

2. Slave 上面的 IO 線程,該線程負責接收 Master 傳過來的 binlog,並寫入 relay log;

3. Slave 上面的 SQL 線程,該線程負責讀取 relay log 並執行;

4. 如果是多線程複製,無論是 5.6 庫級別的假多線程還是 MariaDB 或者 5.7 的真正的多線程複製, SQL 線程只做 coordinator,只負責把 relay log 中的 binlog讀出來然後交給 worker 線程, woker 線程負責具體 binlog event 的執行;

(3)MySQL如何保證複製過程中數據一致性及減少數據同步延時

一致性主要有以下幾個方面:

1.在 MySQL5.5 以及之前, slave 的 SQL 線程執行的 relay log 的位置只能保存在文件( relay-log.info)裏面,並且該文件默認每執行 10000 次事務做一次同步到磁盤, 這意味着 slave 意外 crash 重啓時, SQL 線程執行到的位置和數據庫的數據是不一致的,將導致複製報錯,如果不重搭複製,則有可能會導致數據不一致。MySQL 5.6 引入參數 relay_log_info_repository,將該參數設置爲 TABLE 時, MySQL 將 SQL 線程執行到的位置存到mysql.slave_relay_log_info 表,這樣更新該表的位置和 SQL 線程執行的用戶事務綁定成一個事務,這樣 slave 意外宕機後, slave 通過 innodb 的崩潰恢復可以把 SQL 線程執行到的位置和用戶事務恢復到一致性的狀態。

2. MySQL 5.6 引入 GTID 複製,每個 GTID 對應的事務在每個實例上面最多執行一次, 這極大地提高了複製的數據一致性;

3. MySQL 5.5 引入半同步複製, 用戶安裝半同步複製插件並且開啓參數後,設置超時時間,可保證在超時時間內如果 binlog 不傳到 slave 上面,那麼用戶提交事務時不會返回,直到超時後切成異步複製,但是如果切成異步之前用戶線程提交時在 master 上面等待的時候,事務已經提交,該事務對 master上面的其他 session 是可見的,如果這時 master 宕機,那麼到 slave 上面該事務又不可見了,該問題直到 5.7 才解決;

4. MySQL 5.7 引入無損半同步複製,引入參 rpl_semi_sync_master_wait_point,該參數默認爲 after_sync,指的是在切成半同步之前,事務不提交,而是接收到 slave 的 ACK 確認之後才提交該事務,從此,複製真正可以做到無損的了。

5.可以再說一下 5.7 的無損複製情況下, master 意外宕機,重啓後發現有 binlog沒傳到 slave 上面,這部分 binlog 怎麼辦???分 2 種情況討論, 1 宕機時已經切成異步了, 2 是宕機時還沒切成異步???這個怎麼判斷宕機時有沒有切成異步呢???分別怎麼處理???

延時性:

5.5 是單線程複製, 5.6 是多庫複製(對於單庫或者單表的併發操作是沒用的), 5.7 是真正意義的多線程複製,它的原理是基於 group commit, 只要master 上面的事務是 group commit 的,那 slave 上面也可以通過多個 worker線程去併發執行。和 MairaDB10.0.0.5 引入多線程複製的原理基本一樣。

(4)工作遇到的複製 bug 的解決方法

5.6 的多庫複製有時候自己會停止,我們寫了一個腳本重新 start slave;待補充…

二、MySQL中myisam與innodb的區別,至少5點

(1)問5點不同

1.InnoDB支持事物,而MyISAM不支持事物

2.InnoDB支持行級鎖,而MyISAM支持表級鎖

3.InnoDB支持MVCC, 而MyISAM不支持

4.InnoDB支持外鍵,而MyISAM不支持

5.InnoDB不支持全文索引,而MyISAM支持。

6.InnoDB不能通過直接拷貝表文件的方法拷貝表到另外一臺機器, myisam 支持

7.InnoDB表支持多種行格式, myisam 不支持

8.InnoDB是索引組織表, myisam 是堆表

(2)innodb引擎的4大特性

1.插入緩衝(insert buffer)

2.二次寫(double write)

3.自適應哈希索引(ahi)

4.預讀(read ahead)

(3)各種不同 mysql 版本的Innodb的改進

MySQL5.6 下 Innodb 引擎的主要改進:

1.online DDL

2. memcached NoSQL 接口

3.transportable tablespace( alter table discard/import tablespace)

4.MySQL 正常關閉時,可以 dump 出 buffer pool 的( space, page_no),重啓時 reload,加快預熱速度

5.索引和表的統計信息持久化到 mysql.innodb_table_stats 和mysql.innodb_index_stats,可提供穩定的執行計劃

6.Compressed row format 支持壓縮表

MySQL 5.7 innodb 引擎主要改進

1.修改 varchar 字段長度有時可以使用 online DDL

2. Buffer pool 支持在線改變大小

3.Buffer pool 支持導出部分比例

4.支持新建 innodb tablespace,並可以在其中創建多張表

5.磁盤臨時表採用 innodb 存儲,並且存儲在 innodb temp tablespace 裏面,以前是 myisam 存儲

6.透明表空間壓縮功能

(4)2者select count(*)哪個更快,爲什麼

myisam更快,因爲myisam內部維護了一個計數器,可以直接調取。

(5)2 者的索引的實現方式

都是 B+樹索引, Innodb 是索引組織表, myisam 是堆表, 索引組織表和堆表的區別要熟悉

三、MySQL中varchar與char的區別以及varchar(50)中的50代表的涵義

(1)varchar與char的區別

在單字節字符集下, char(N) 在內部存儲的時候總是定長, 而且沒有變長字段長度列表中。在多字節字符集下面, char(N)如果存儲的字節數超過 N,那麼 char(N)將和 varchar(N)沒有區別。在多字節字符集下面,如果存儲的字節數少於 N,那麼存儲 N 個字節,後面補空格,補到 N 字節長度。都存儲變長的數據和變長字段長度列表。varchar(N)無論是什麼字節字符集,都是變長的,即都存儲變長數據和變長字段長度列表

(2)varchar(50)中50的涵義

最多存放50個字符,varchar(50)和(200)存儲hello所佔空間一樣,但後者在排序時會消耗更多內存,因爲order by col採用fixed_length計算col長度(memory引擎也一樣)。在早期 MySQL 版本中, 50 代表字節數,現在代表字符數。

(3)int(20)中20的涵義

是指顯示字符的長度

不影響內部存儲,只是影響帶 zerofill 定義的 int 時,前面補多少個 0,易於報表展示

(4)mysql爲什麼這麼設計

對大多數應用沒有意義,只是規定一些工具用來顯示字符的個數;int(1)和int(20)存儲和計算均一樣;

四、innodb的事務與日誌的實現方式

(1)有多少種日誌

redo和undo

(2)日誌的存放形式

redo:在頁修改的時候,先寫到 redo log buffer 裏面, 然後寫到 redo log 的文件系統緩存裏面(fwrite),然後再同步到磁盤文件( fsync)。

Undo:在 MySQL5.5 之前, undo 只能存放在 ibdata*文件裏面, 5.6 之後,可以通過設置 innodb_undo_tablespaces 參數把 undo log 存放在 ibdata*之外。

(3)事務是如何通過日誌來實現的,說得越深入越好

基本流程如下:

因爲事務在修改頁時,要先記 undo,在記 undo 之前要記 undo 的 redo, 然後修改數據頁,再記數據頁修改的 redo。Redo(裏面包括 undo 的修改) 一定要比數據頁先持久化到磁盤。當事務需要回滾時,因爲有 undo,可以把數據頁回滾到前鏡像的

狀態,崩潰恢復時,如果 redo log 中事務沒有對應的 commit 記錄,那麼需要用 undo把該事務的修改回滾到事務開始之前。如果有 commit 記錄,就用 redo 前滾到該事務完成時並提交掉。

五、MySQL binlog的幾種日誌錄入格式以及區別

(1) 各種日誌格式的涵義

1.Statement:每一條會修改數據的sql都會記錄在binlog中。

優點:不需要記錄每一行的變化,減少了binlog日誌量,節約了IO,提高性能。(相比row能節約多少性能 與日誌量,這個取決於應用的SQL情況,正常同一條記錄修改或者插入row格式所產生的日誌量還小於Statement產生的日誌量,

但是考慮到如果帶條 件的update操作,以及整表刪除,alter表等操作,ROW格式會產生大量日誌,因此在考慮是否使用ROW格式日誌時應該跟據應用的實際情況,其所 產生的日誌量會增加多少,以及帶來的IO性能問題。)

缺點:由於記錄的只是執行語句,爲了這些語句能在slave上正確運行,因此還必須記錄每條語句在執行的時候的 一些相關信息,以保證所有語句能在slave得到和在master端執行時候相同 的結果。另外mysql 的複製,

像一些特定函數功能,slave可與master上要保持一致會有很多相關問題(如sleep()函數, last_insert_id(),以及user-defined functions(udf)會出現問題).

使用以下函數的語句也無法被複制:

* LOAD_FILE()

* UUID()

* USER()

* FOUND_ROWS()

* SYSDATE() (除非啓動時啓用了 --sysdate-is-now 選項)

同時在INSERT ...SELECT 會產生比 RBR 更多的行級鎖

2.Row:不記錄sql語句上下文相關信息,僅保存哪條記錄被修改。

優點:binlog中可以不記錄執行的sql語句的上下文相關的信息,僅需要記錄那一條記錄被修改成什麼了。所以rowlevel的日誌內容會非常清楚的記錄下 每一行數據修改的細節。而且不會出現某些特定情況下的存儲過程,或function,以及trigger的調用和觸發無法被正確複製的問題

缺點:所有的執行的語句當記錄到日誌中的時候,都將以每行記錄的修改來記錄,這樣可能會產生大量的日誌內容,比 如一條update語句,修改多條記錄,則binlog中每一條修改都會有記錄,這樣造成binlog日誌量會很大,特別是當執行alter table之類的語句的時候,由於表結構修改,每條記錄都發生改變,那麼該表每一條記錄都會記錄到日誌中。

3.Mixedlevel: 是以上兩種level的混合使用,一般的語句修改使用statment格式保存binlog,如一些函數,statement無法完成主從複製的操作,則 採用row格式保存binlog,MySQL會根據執行的每一條具體的sql語句來區分對待記錄的日誌形式,

也就是在Statement和Row之間選擇 一種.新版本的MySQL中隊row level模式也被做了優化,並不是所有的修改都會以row level來記錄,像遇到表結構變更的時候就會以statement模式來記錄。至於update或者delete等修改數據的語句,還是會記錄所有行的變更。

(2)適用場景

在一條 SQL 操作了多行數據時, statement 更節省空間, row 更佔用空間。但是 row模式更可靠。

(3)結合第一個問題,每一種日誌格式在複製中的優劣

Statement 可能佔用空間會相對小一些,傳送到 slave 的時間可能也短,但是沒有 row模式的可靠。Row 模式在操作多行數據時更佔用空間, 但是可靠。

六、下MySQL數據庫cpu飆升到500%的話他怎麼處理?

當 cpu 飆升到 500%時,先用操作系統命令 top 命令觀察是不是 mysqld 佔用導致的,如果不是,找出佔用高的進程,並進行相關處理。如果是 mysqld 造成的, show processlist,看看裏面跑的 session 情況,是不是有消耗資源的 sql 在運行。找出消耗高的 sql,看看執行計劃是否準確, index 是否缺失,或者實在是數據量太大造成。一般來說,肯定要 kill 掉這些線程(同時觀察 cpu 使用率是否下降),等進行相應的調整(比如說加索引、改 sql、改內存參數)之後,再重新跑這些 SQL。也有可能是每個 sql 消耗資源並不多,但是突然之間,有大量的 session 連進來導致 cpu 飆升,這種情況就需要跟應用一起來分析爲何連接數會激增,再做出相應的調整,比如說限制連接數等

七、sql優化

(1)、explain出來的各種item的意義

id:每個被獨立執行的操作的標誌,表示對象被操作的順序。一般來說, id 值大,先被執行;如果 id 值相同,則順序從上到下。

select_type:查詢中每個 select 子句的類型。

table:名字,被操作的對象名稱,通常的表名(或者別名),但是也有其他格式。

partitions:匹配的分區信息。

type:join 類型。

possible_keys:列出可能會用到的索引。

key:實際用到的索引。

key_len:用到的索引鍵的平均長度,單位爲字節。

ref:表示本行被操作的對象的參照對象,可能是一個常量用 const 表示,也可能是其他表的

key 指向的對象,比如說驅動表的連接列。

rows:估計每次需要掃描的行數。

filtered:rows*filtered/100 表示該步驟最後得到的行數(估計值)。

extra:重要的補充信息。

(2)、profile的意義以及使用場景

Profile 用來分析 sql 性能的消耗分佈情況。當用 explain 無法解決慢 SQL 的時候,需要用profile 來對 sql 進行更細緻的分析,找出 sql 所花的時間大部分消耗在哪個部分,確認 sql的性能瓶頸。

(3)、explain 中的索引問題

Explain 結果中,一般來說,要看到儘量用 index(type 爲 const、 ref 等, key 列有值),避免使用全表掃描(type 顯式爲 ALL)。比如說有 where 條件且選擇性不錯的列,需要建立索引。

被驅動表的連接列,也需要建立索引。被驅動表的連接列也可能會跟 where 條件列一起建立聯合索引。當有排序或者 group by 的需求時,也可以考慮建立索引來達到直接排序和彙總的需求。

歡迎大家關注我的公種浩【程序員追風】,文章都會在裏面更新,整理的資料也會放在裏面。

八、備份計劃,mysqldump以及xtranbackup的實現原理

(1)備份計劃

視庫的大小來定,一般來說 100G 內的庫,可以考慮使用 mysqldump 來做,因爲 mysqldump更加輕巧靈活,備份時間選在業務低峯期,可以每天進行都進行全量備份(mysqldump 備份

出來的文件比較小,壓縮之後更小)。100G 以上的庫,可以考慮用 xtranbackup 來做,備份速度明顯要比 mysqldump 要快。一般是選擇一週一個全備,其餘每天進行增量備份,備份時間爲業務低峯期。

(2)備份恢復時間

物理備份恢復快,邏輯備份恢復慢

這裏跟機器,尤其是硬盤的速率有關係,以下列舉幾個僅供參考

20G的2分鐘(mysqldump)

80G的30分鐘(mysqldump)

111G的30分鐘(mysqldump)

288G的3小時(xtra)

3T的4小時(xtra)

邏輯導入時間一般是備份時間的5倍以上

(3)備份恢復失敗如何處理

首先在恢復之前就應該做足準備工作,避免恢復的時候出錯。比如說備份之後的有效性檢查、權限檢查、空間檢查等。如果萬一報錯,再根據報錯的提示來進行相應的調整。

(4)mysqldump和xtrabackup實現原理

mysqldump

mysqldump 屬於邏輯備份。加入--single-transaction 選項可以進行一致性備份。後臺進程會先設置 session 的事務隔離級別爲 RR(SET SESSION TRANSACTION ISOLATION LEVELREPEATABLE READ),之後顯式開啓一個事務(START TRANSACTION /*!40100 WITH CONSISTENTSNAPSHOT */),這樣就保證了該事務裏讀到的數據都是事務事務時候的快照。之後再把表的數據讀取出來。如果加上--master-data=1 的話,在剛開始的時候還會加一個數據庫的讀鎖(FLUSH TABLES WITH READ LOCK),等開啓事務後,再記錄下數據庫此時 binlog 的位置(showmaster status),馬上解鎖,再讀取表的數據。等所有的數據都已經導完,就可以結束事務

Xtrabackup:

xtrabackup 屬於物理備份,直接拷貝表空間文件,同時不斷掃描產生的 redo 日誌並保存下來。最後完成 innodb 的備份後,會做一個 flush engine logs 的操作(老版本在有 bug,在5.6 上不做此操作會丟數據),確保所有的 redo log 都已經落盤(涉及到事務的兩階段提交

概念,因爲 xtrabackup 並不拷貝 binlog,所以必須保證所有的 redo log 都落盤,否則可能會丟最後一組提交事務的數據)。這個時間點就是 innodb 完成備份的時間點,數據文件雖然不是一致性的,但是有這段時間的 redo 就可以讓數據文件達到一致性(恢復的時候做的事

情)。然後還需要 flush tables with read lock,把 myisam 等其他引擎的表給備份出來,備份完後解鎖。這樣就做到了完美的熱備。

九、mysqldump中備份出來的sql,如果我想sql文件中,一行只有一個insert....value()的話,怎麼辦?如果備份需要帶上master的複製點信息怎麼辦?

--skip-extended-insert [root@helei-zhuanshu ~]# mysqldump -uroot -p helei --skip-extended-insert Enter password: KEY `idx_c1` (`c1`), KEY `idx_c2` (`c2`) ) ENGINE=InnoDB AUTO_INCREMENT=51 DEFAULT CHARSET=latin1; /*!40101 SET character_set_client = @saved_cs_client */; -- -- Dumping data for table `helei` -- LOCK TABLES `helei` WRITE; /*!40000 ALTER TABLE `helei` DISABLE KEYS */; INSERT INTO `helei` VALUES (1,32,37,38,'2016-10-18 06:19:24','susususususususususususu'); INSERT INTO `helei` VALUES (2,37,46,21,'2016-10-18 06:19:24','susususususu'); INSERT INTO `helei` VALUES (3,21,5,14,'2016-10-18 06:19:24','susu');

十、500臺db,在最快時間之內重啓

可以使用批量 ssh 工具 pssh 來對需要重啓的機器執行重啓命令。也可以使用 salt(前提是客戶端有安裝 salt)或者 ansible( ansible 只需要 ssh 免登通了就行)等多線程工具同時操作多臺服務器

十一、innodb的讀寫參數優化

(1)讀取參數

global buffer 以及 local buffer; Global buffer: Innodb_buffer_pool_size innodb_log_buffer_size innodb_additional_mem_pool_size local buffer(下面的都是 server 層的 session 變量,不是 innodb 的): Read_buffer_size Join_buffer_size Sort_buffer_size Key_buffer_size Binlog_cache_size

(2)寫入參數

innodb_flush_log_at_trx_commit innodb_buffer_pool_size insert_buffer_size innodb_double_write innodb_write_io_thread innodb_flush_method

(3)與IO相關的參數

innodb_write_io_threads = 8 innodb_read_io_threads = 8 innodb_thread_concurrency = 0 Sync_binlog Innodb_flush_log_at_trx_commit Innodb_lru_scan_depth Innodb_io_capacity Innodb_io_capacity_max innodb_log_buffer_size innodb_max_dirty_pages_pct

(4)緩存參數以及緩存的適用場景

query cache/query_cache_type

並不是所有表都適合使用query cache。造成query cache失效的原因主要是相應的table發生了變更

第一個:讀操作多的話看看比例,簡單來說,如果是用戶清單表,或者說是數據比例比較固定,比如說商品列表,是可以打開的,前提是這些庫比較集中,數據庫中的實務比較小。

第二個:我們“行騙”的時候,比如說我們競標的時候壓測,把query cache打開,還是能收到qps激增的效果,當然前提示前端的連接池什麼的都配置一樣。大部分情況下如果寫入的居多,訪問量並不多,那麼就不要打開,例如社交網站的,10%的人產生內容,其餘的90%都在消費,打開還是效果很好的,但是你如果是qq消息,或者聊天,那就很要命。

第三個:小網站或者沒有高併發的無所謂,高併發下,會看到 很多 qcache 鎖 等待,所以一般高併發下,不建議打開query cache

十二、你是如何監控你們的數據庫的?你們的慢日誌都是怎麼查詢的?

監控的工具有很多,例如zabbix,lepus,我這裏用的是lepus

十三、你是否做過主從一致性校驗,如果有,怎麼做的,如果沒有,你打算怎麼做?

主從一致性校驗有多種工具 例如checksum、mysqldiff、pt-table-checksum等

十四、表中有大字段X(例如:text類型),且字段X不會經常更新,以讀爲爲主,請問您是選擇拆成子表,還是繼續放一起?寫出您這樣選擇的理由

答:拆帶來的問題:連接消耗 + 存儲拆分空間;不拆可能帶來的問題:查詢性能;

如果能容忍拆分帶來的空間問題,拆的話最好和經常要查詢的表的主鍵在物理結構上放置在一起(分區) 順序IO,減少連接消耗,最後這是一個文本列再加上一個全文索引來儘量抵消連接消耗

如果能容忍不拆分帶來的查詢性能損失的話:上面的方案在某個極致條件下肯定會出現問題,那麼不拆就是最好的選擇

十五、MySQL中InnoDB引擎的行鎖是通過加在什麼上完成(或稱實現)的?爲什麼是這樣子的?

答:InnoDB是基於索引來完成行鎖

例: select * from tab_with_index where id = 1 for update;

for update 可以根據條件來完成行鎖鎖定,並且 id 是有索引鍵的列,

如果 id 不是索引鍵那麼InnoDB將完成表鎖,,併發將無從談起

十六、如何從mysqldump產生的全庫備份中只恢復某一個庫、某一張表?

全庫備份

[root@HE1 ~]# mysqldump -uroot -p --single-transaction -A --master-data=2 >dump.sql

只還原erp庫的內容

[root@HE1 ~]# mysql -uroot -pMANAGER erp --one-database <dump.sql

可以看出這裏主要用到的參數是--one-database簡寫-o的參數,極大方便了我們的恢復靈活性

那麼如何從全庫備份中抽取某張表呢,全庫恢復,再恢復某張表小庫還可以,大庫就很麻煩了,那我們可以利用正則表達式來進行快速抽取,具體實現方法如下:

從全庫備份中抽取出t表的表結構

[root@HE1 ~]# sed -e'/./{H;$!d;}' -e 'x;/CREATE TABLE `t`/!d;q' dump.sql

DROP TABLE IF EXISTS`t`;

/*!40101 SET@saved_cs_client =@@character_set_client */;

/*!40101 SETcharacter_set_client = utf8 */;

CREATE TABLE `t` (

`id` int(10) NOT NULL AUTO_INCREMENT,

`age` tinyint(4) NOT NULL DEFAULT '0',

`name` varchar(30) NOT NULL DEFAULT '',

PRIMARY KEY (`id`)

) ENGINE=InnoDBAUTO_INCREMENT=4 DEFAULT CHARSET=utf8;

/*!40101 SETcharacter_set_client = @saved_cs_client */;

從全庫備份中抽取出t表的內容

[root@HE1 ~]# grep'INSERT INTO `t`' dump.sql

INSERT INTO `t`VALUES (0,0,''),(1,0,'aa'),(2,0,'bbb'),(3,25,'helei');十七、在當前的工作中,你碰到到的最大的 mysql db 問題以及如何解決的?

可以選擇一個處理過的比較棘手的案例,或者選擇一個老師在課程上講過的死鎖的案例;沒有及時 Purge + insert 唯一索引造成的死鎖:具體案例可以參考學委筆記。

十八、請簡潔地描述下 MySQL 中 InnoDB 支持的四種事務隔離級別名稱,以及逐級之間的區別?

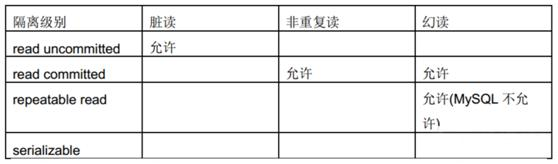

(1)事物的4種隔離級別

讀未提交(read uncommitted)

讀已提交(read committed)

可重複讀(repeatable read)

串行(serializable)

(2)不同級別的現象

Read Uncommitted:可以讀取其他 session 未提交的髒數據。

Read Committed:允許不可重複讀取,但不允許髒讀取。提交後,其他會話可以看到提交的數據。

Repeatable Read: 禁止不可重複讀取和髒讀取、以及幻讀(innodb 獨有)。

Serializable: 事務只能一個接着一個地執行,但不能併發執行。事務隔離級別最高。

不同的隔離級別有不同的現象,並有不同的鎖定/併發機制,隔離級別越高,數據庫的併發性就越差。

最後

歡迎大家一起交流,喜歡文章記得點個贊喲,感謝支持!