摘要: 本文講的是“信息瓶頸”理論揭示深度學習本質,Hinton說他要看1萬遍,利用深度神經網絡的機器已經學會了交談、開車,在玩視頻遊戲和下圍棋時擊敗了世界冠軍,還能做夢、畫畫,幫助進行科學發現,但同時它們也深深地讓其發明者困惑,誰也沒有料到所謂的“深度學習”算法能做得這麼好。

本文講的是“信息瓶頸”理論揭示深度學習本質,Hinton說他要看1萬遍,利用深度神經網絡的機器已經學會了交談、開車,在玩視頻遊戲和下圍棋時擊敗了世界冠軍,還能做夢、畫畫,幫助進行科學發現,但同時它們也深深地讓其發明者困惑,誰也沒有料到所謂的“深度學習”算法能做得這麼好。沒有基本的原則指引這些學習系統,除了一些模糊的來自人類大腦的設計靈感(而關於這一點,實際上也沒有人真正懂得多少)。

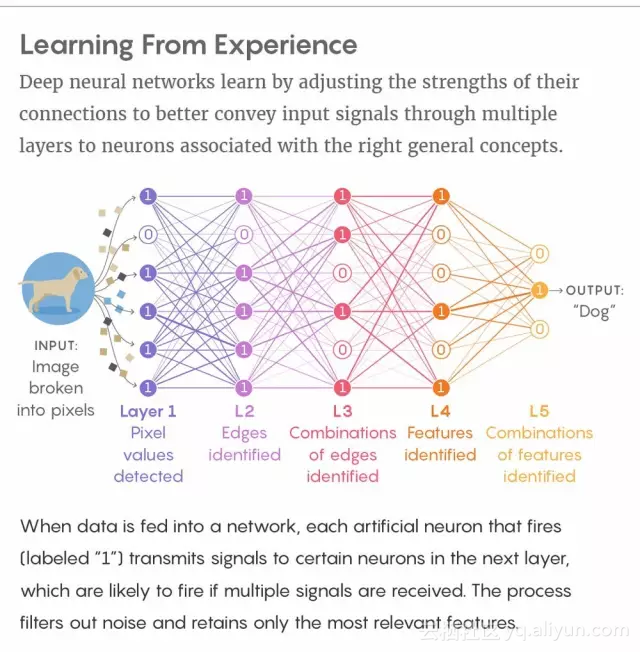

像大腦一樣,深度神經網絡也有很多層神經元。當神經元被激活時,它會發出信號,連接上面一層的神經元。在深度學習的過程中,網絡中的連接會根據需要被加強或減弱,從而讓網絡更好地根據輸入(例如一張狗的照片的像素)發送信號,信號層層向上,經過所有相關的神經元,這些神經元都與“狗”這個概念的高層抽象有關。一個深度神經網絡在“學習”過數以千計的狗的照片後,能像人一樣準確地識別出從未見過的照片中的狗。

從具體個例到通用概念的飛躍,讓深度神經網絡擁有了如同人類在推理、創作時所展現出的“智能”。專業人員想知道,是什麼賦予了神經網絡泛化的能力,也想知道人類的大腦在多大程度上也在進行類似的活動。

近年來少有的乾貨演講,Hinton說他要看上10000遍才懂

上月,在柏林舉行的一場演講爲這一疑問提供了一個可能的回答,這場演講的視頻在人工智能研究人員間廣爲分享。

演講中,希伯來大學的計算機科學家和神經學家Naftali Tishby,提出了一種解釋深度學習工作原理的新理論,並給出了證據支撐。Tishby認爲,深度神經網絡根據一種被稱爲“信息瓶頸”(information bottleneck)的過程在學習,他和兩位合作者最早在1999年對這一過程進行了純理論方面的描述。

信息瓶頸理論認爲,網絡像把信息從一個瓶頸中擠壓出去一般,去除掉那些含有無關細節的噪音輸入數據,只保留與通用概念(general concept)最相關的特徵。Tishby和他的學生Ravid Shwartz-Ziv的最新實驗,展示了深度學習過程中這種“擠壓”是如何發生的(至少在他們所研究的案例裏)。

Tishby的發現在AI研究圈激起了強烈的反向。Google Researc的Alex Alemi說:“我認爲信息瓶頸的想法可能在未來深度神經網絡的研究中非常重要。”Alemi已經開發了新的近似方法,在大規模深度神經網絡中應用信息瓶頸分析。Alemi說,信息瓶頸可能“不僅能夠用於理解爲什麼神經網絡有用,也是用於構建新目標和新網絡架構的理論工具”。

另外一些研究人員則持懷疑態度,認爲信息瓶頸理論不能完全解釋深學習的成功。但是,紐約大學的粒子物理學家Kyle Cranmer——他使用機器學習來分析大型強子對撞機的粒子碰撞——表示,一種通用的學習原理(a general principle of learning),“聽上去有些道理”。

深度學習先驅Geoffrey Hinton在看完Tishby的柏林演講後發電子郵件給Tishby。“這簡直太有趣了,”Hinton寫道:“我還得聽上10,000次才能真正理解它,但如今聽一個演講,裏面有真正原創的想法,而且可能解決重大的問題,真是非常罕見了。”

Tishby認爲,信息瓶頸是學習的一個基本原則,無論是算法也好,蒼蠅也罷,任何有意識的存在或突發行爲的物理學計算,大家最期待的答案——“學習最重要的部分實際上是忘記”。

香農錯了——利用信息論,我們能夠精確定義“相關性”

Tishby很早便開始考慮信息瓶頸的問題,那時候其他研究人員也纔剛剛開始醞釀深度神經網絡,儘管當時無論是信息瓶頸還是深度神經網絡都還沒有得名。那是20世紀80年代,Tishby在思考人類是如何做語音識別的——語音識別是當時AI的一個重大挑戰。Tishby意識到,問題的關鍵是相關性:說出來的一個詞最相關的特徵是什麼,我們又該如何從重音、語調、模糊音等變量中將這個特徵計算出來?在通常情況下,當我們面對現實生活中汪洋大海般的數據時,哪些信號是我們會保留下來的?

“相關信息(relevant information)的概念在歷史上提到了許多次,但從來沒有被正確地形式化,”Tishby在上個月接受採訪時說:“多年來,人們認爲信息論不是考慮相關性的正確方式,這個誤解可以一直追溯到香農本人。”

克勞德·香農,信息論的創始人,從某種程度上說,是香農解放了人類對信息的研究,讓信息能夠以抽象的0、1形式和純粹的數學意義被研究。正如Tishby所說的那樣,香農認爲“信息並非關乎語義”。但是,Tishby認爲,這是不正確的。

Tishby意識到,利用信息論,“你能精確定義‘相關’(relevant)”。

希伯來大學計算機科學家和神經學家Naftali Tishby

假設X是一個複雜的數據集,就像一張狗的照片的像素,而Y是這些數據代表的一個更爲簡單的變量,比如單詞“狗”。你可以任意壓縮X而不丟失預測Y的能力,將X中所有與Y“相關”的信息捕獲下來。在他們1999年的論文中,Tishby和他的共同作者,Fernando Pereira(現在在谷歌)和William Bialek(現在在普林斯頓大學),將這一過程轉換成一個數學優化問題並且提出了數學公式。這是一個沒有殺手級應用的核心基礎概念。

“我沿着這條路在各種不同的情景中思考了30年,”Tishby說:“我唯一的運氣就是深度神經網絡變得如此重要。”

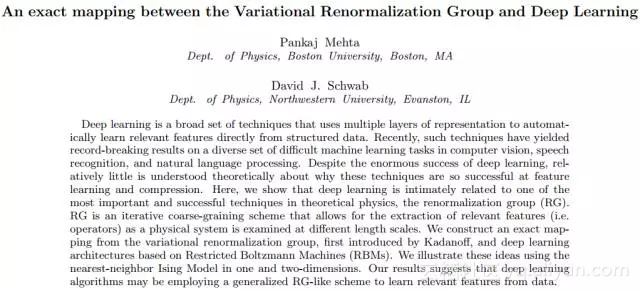

一篇論文的驚人發現:深度學習與物理重整化是完全相同的過程

深度神經網絡背後的概念已經存在了幾十年,但它們在語音和圖像識別任務中的表現在最近幾年纔開始起飛,得益於改進了訓練方案和更強大的計算機處理器。Tishby在讀了物理學家David Schwab和Pankaj Mehta在2014年發表的一篇論文後,開始注意到深度學習與信息瓶頸理論的關聯。

David Schwab和Pankaj Mehta兩人發現,Hinton發明的“深度信念網絡”(DBN),在一種特定的情況下,酷似物理學中的重整化(renormalization),也就是以粗粒度的方式獲取物理系統的細節,從而計算其整體狀態。當Schwab和Mehta將深度信念網絡應用於一個處於“臨界點”的磁力模型時(這時該系統是分形,在任意尺度都自相似),他們發現,網絡會自動使用重整化般的過程來發現模型的狀態。

這一發現令人震驚,正如生物物理學家Ilya Nemenman當時評論所說的那樣,它表明了“在統計物理的背景下提取相關特徵和在深度學習的背景下提取相關特徵並不只是類似,而是完完全全的同一個。”

物理學家David Schwab和Pankaj Mehta在2014年的論文,證明在特定情況下深度學習等同於物理中的重整化技術,這讓Tishby注意到信息瓶頸理論與深度學習之間的關聯

唯一的問題是,在一般情況下,現實世界並不是分形。Cranmer說:“我不會說[重整化步驟]就是深度學習在處理自然圖像時效果這麼好的原因。”

但Tishby——他當時正在接受胰腺癌化療——意識到,無論是粗粒度過程還是深度學習,都可以被一個更廣泛通用的想法所涵蓋。“對科學和對我以前想法的思考是我的治療和康復的重要組成部分,”Tishby說。

Naftali Tishby的學生Noga Zaslavsky(左)和Ravid Shwartz-Ziv,他們幫助開發了深度學習信息瓶頸理論。

信息瓶頸:網絡在抽取相關性時的理論邊界

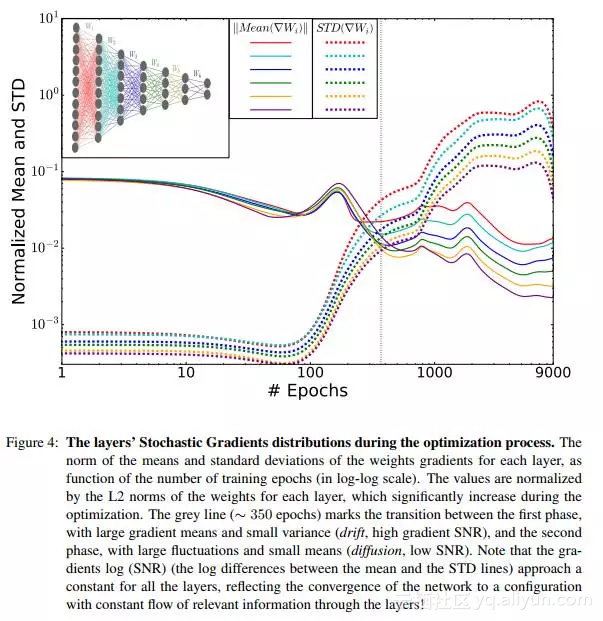

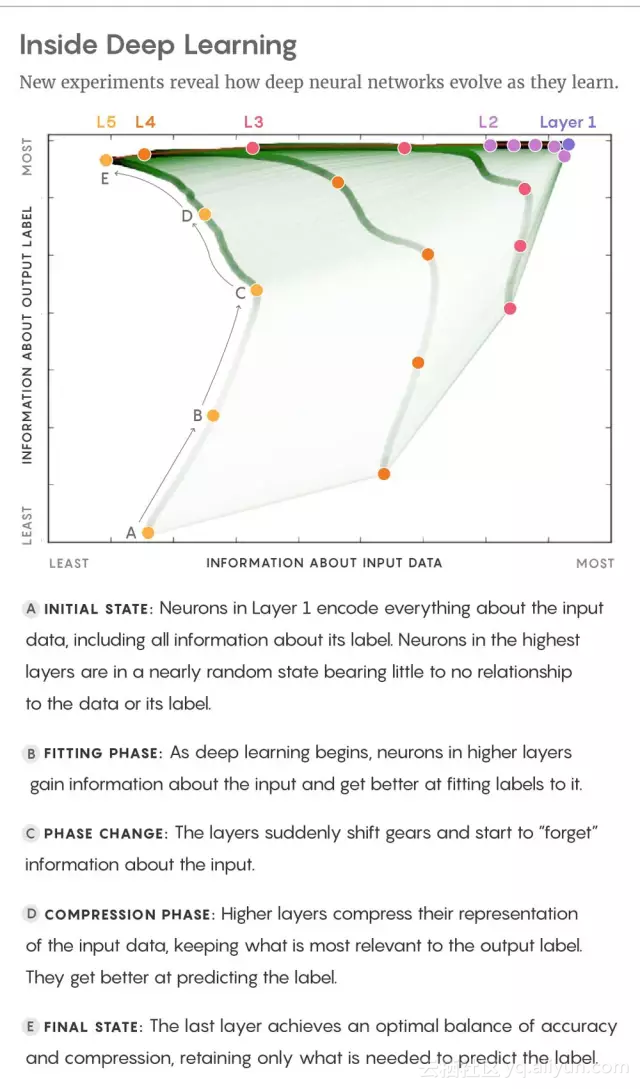

2015年,Tishby和他的學生Noga Zaslavsky假設深度學習是一個信息瓶頸過程,儘可能地壓縮噪聲數據,同時保留數據所代表的信息。Tishby和Shwartz-Ziv對深度神經網絡的新實驗揭示了瓶頸過程如何實際發生的。在一種情況下,研究人員使用小型神經網絡,使用隨機梯度下降和BP,經過訓練後,能夠用1或0(也即“是狗”或“不是狗”)標記輸入數據,並給出其282個神經連接隨機初始強度,然後跟蹤了網絡在接收3000個樣本輸入數據集後發生了什麼。

實驗中,Tishby和Shwartz-Ziv跟蹤了每層網絡保留了多少輸入中的信息和輸出標籤中的信息。結果發現,信息經過逐層傳遞,最終收斂到信息瓶頸的理論邊界:也就是Tishby、Pereira和Bialek在他們1999年論文中推導出的理論界限,代表系統在抽取相關信息時能夠做到的最好的情況。在這個邊界上,網絡在沒有犧牲準確預測標籤能力的情況下,儘可能地壓縮輸入。

Tishby和Shwartz-Ziv還提出了一個有趣的發現,即深度學習分爲兩個階段:一個簡短的“擬合”階段,在此期間,網絡學着去標註其訓練數據,以及一個更長時間的“壓縮”階段,在這個階段網絡變得能夠泛化,也即標記新的測試數據。

作者在論文中指出,他們在實驗中首次觀察到了隨機梯度下降優化過程中兩個獨特的階段,經驗誤差最小化(ERM)和表示壓縮。上圖展示了SGD過程中信息逐層傳遞收斂的情況。

在深度神經網絡通過隨機梯度下降調整其連接權重的過程中,首先,網絡存儲的關於輸入的數據會大致保持恆定或者稍微增加一點點,這時網絡連接會進行調整,爲輸入中的模式進行編碼,更好地擬合標籤。有一些專家也將這個階段與記憶進行了類比。

然後,學習切換到壓縮階段。網絡開始扔掉一些關於輸入數據的信息,只跟蹤最強的特徵——與輸出標籤最相關的那些關聯(correlation)。這是因爲,在隨機梯度下降的每次迭代中,訓練數據中或多或少的意外相關性會告訴網絡做不同的事情,在隨機遊走(random walk)中上下撥動神經連接的強度。這種隨機化與壓縮系統輸入數據的表示(representation)實際上是相同的。看這個例子,一些狗的照片的背景中可能有房子,而其他的照片沒有。在網絡不停地訓練過程中,它可能會“忘記”一些照片中房屋和狗之間的相關性,因爲其他照片抵消了這一點。Tishby和Shwartz-Ziv認爲,正是對細節的遺忘使得系統能夠形成通用的概念。實際上,他們的實驗表明,深度神經網絡在壓縮階段提高了泛化性能,在標記測試數據方面變得更好。

信息瓶頸能否解釋所有的深度學習?

信息瓶頸是否能解釋所有深度學習,除了壓縮以外是否還有其他的泛化途徑,這些還有待觀察。一些AI專家認爲,Tishby的想法是近期出現的關於深度學習最重要的理論見解之一。不過,哈佛大學AI研究員和理論神經科學家Andrew Saxe指出,某些非常大的深度神經網絡似乎不需要專門的壓縮階段來泛化。研究人員會用一種叫做“早期停止”(early stopping)的方式進行編程,減少訓練,從一開始就防止網絡編碼過多的相關性。

Tishby認爲,Saxe及其同事分析的網絡模型與標準的深度神經網絡架構有所不同,但是即使如此,信息瓶頸的理論界限比其他方法更好地定義了這些網絡的泛化性能。關於瓶頸是否適用於較大神經網絡,Tishby和Shwartz-Ziv的最新實驗部分解決了這一問題。在最新的這項實驗中,Tishby他們訓練了更大的,擁有33萬連接的深度神經網絡,識別美國國家標準和技術研究所數據庫(Modified National Institute of Standards and Technology database)中60,000張手寫數字的圖像,這也是衡量深度學習算法性能的一個知名基準。

Tishby和Shwartz-Ziv觀察到了同樣的現象,網絡收斂到了信息瓶頸的理論界限;他們也觀察到了深度學習那兩個截然不同的階段,並且與較小的網絡相比,大規模網絡在這兩個階段的轉換更加明顯。

“我現在完全相信這是一個普遍現象。”Tishby說。

人與機器:學習過程中最重要的,是遺忘

大腦如何從我們的感官中篩選信號並將其提升到意識水平的謎團驅使了早期AI研究者對深度神經網絡的興趣,他們希望逆向設計大腦的學習規則。時至今日,AI從業者在技術進步的狂熱中,已經在很大程度上放棄了這一點,迷醉於提高性能而不考慮生物學上的合理性。不過,在他們打造的思維機器能力不斷提升的過程中,許多研究人員仍然希望,這些探索能夠揭示關於學習和智能的通用見解。

紐約大學心理學和數據科學助理教授Brenden Lake致力於研究人類和機器學習的異同,他認爲Tishby的發現是“打開神經網絡黑匣子的重要一步”。但Lake強調說,大腦代表了一個更大、更黑的黑盒子。成年人的大腦擁有860億個神經元,之間更有數百萬億個連接,很可能採用了衆多策略來加強泛化,遠遠超越嬰兒期發生的基本的圖像和聲音識別的學習過程,後者在很大程度上類似當前的深度學習。

Lake說,Tishby觀察到的擬合和壓縮階段,似乎並不能對應到兒童學習手寫字符的過程中。 人類孩子學習認字寫字,並不需要看數千個字符並在比較長的時間中壓縮他們思維中的表示(representation)。事實上,人類兒童可以從一個樣本中學習。Lake和他的同事構建模型表明,大腦可能會把新的字符解構成一系列的筆畫——以前就有的思維表示,從而將字母(letter)的概念加入到先前的知識大廈中,“而不是像標準的機器學習算法一樣,將一個字母作爲像素圖案來學習,通過映射特徵學習概念”。Lake說,人類建立了一個簡單的因果模型——一個更短的泛化路徑。

這種想法可能爲AI研究社區帶來啓發,進一步推動兩個領域彼此間的往來。Tishby認爲,他的信息瓶頸理論最終將被證明在兩門學科中都有用,可能在人類學習中採取一種比AI學習更泛化的表示。信息瓶頸理論的一個直接應用,便是更好地瞭解人類神經網絡和人工神經網絡可以解決哪些問題。

“它給出了可以學習的問題的完整描述,”Tishby說:“這些都是我可以在輸入中消除噪音,而不會損害我分類能力的問題。例如自然視覺、語音識別。這些也正是我們的大腦可以應付的問題。”

同時,人類神經網絡和人工神經網絡都無法很好地解決另一些問題,那就是每個細節都很重要,因此無法去除信息的問題。例如,大多數人不能快速地在心裏將兩個數字相乘。Tishby說:“我們有一大堆類似這樣的問題,改變一個變量都會引發全局變化的邏輯問題。例如離散問題、加密問題。我不認爲深度學習都幫助我破譯密碼。”

泛化——或者說遍歷信息瓶頸——意味着捨棄一些細節。這對心算不好,但心算並不是大腦的主要任務。我們擅長在人羣中尋找熟悉的面孔,在嘈雜、混亂的世界中對尋找顯著信號的秩序。正如Naftali Tishby所說,學習中最重要的,實際上是遺忘。