2 測試環境

Eclipse-version : Juno Service Release 1,hadoop-version hadoop-1.0.4,hbase -version hbase-0.92.0, jdk-version: 1.6.0_31

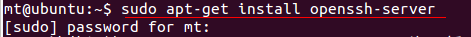

3 ssh-server安裝

1 在ubuntu 12.04的版本中已經安裝了ssh-client,這裏還需要進行ssh-server的安裝。安裝如下圖:

圖-ssh-server安裝

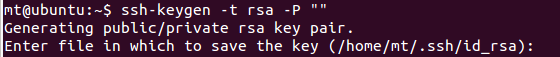

2 使用主節點上的ssh-keygen生成rsa密鑰對,務必避免輸入密碼,否則每次節點啓動的時候都會提示輸入密碼。生成方式如下(一路回車即可):

圖-keygen生成

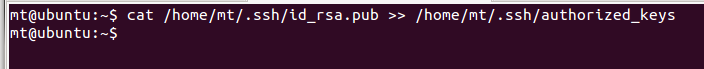

3 對生成的密鑰進行授權:

圖-授權

注:在生成密鑰對時需要注意用戶,如果是普通用戶則在生成keygen的時候不需要加sudo ex:ssh-keygen -t rsa -P “”。如果爲管理員賬戶則需要加入sudo來執行 ex: sudo ssh-keygen -t rsa -P “”

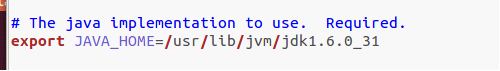

4 hadoop相關配置(前提條件是要安裝ssh-server,jdk)

1. 將下載的hadoop壓縮文件進行解壓,我解壓的目錄是在 “下載” 目錄。

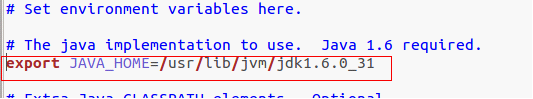

2. 對解壓的hadoop進行配置,打開conf/目錄。編輯hadoop-env.sh文件

對裏面的java_home進行設置。

圖- java_home設置

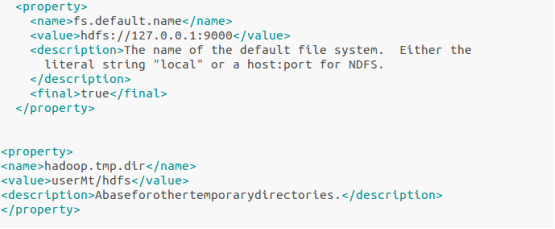

3.對core_site.xml文件進行配置,以下分別對主機節點的地址和存儲文件的路徑進行配置,文件路徑默認情況是存在/tmp/目錄下的。

圖- core-site.xml配置

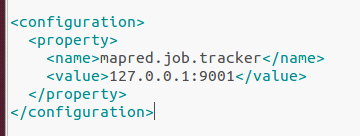

4. 對mapred-site.xml進行配置,以下是對job的主機端口的配置

圖 - mapred-site.xml設置

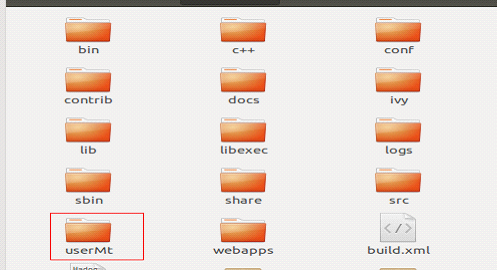

5.在啓動主機之前學要對hdfs系統進行格式化。Bin/hadoop namenode -format 格式化之後會在你配置文件給定的目錄中生成一個hdfs的工作目錄。

圖-hdfs工作目錄生成

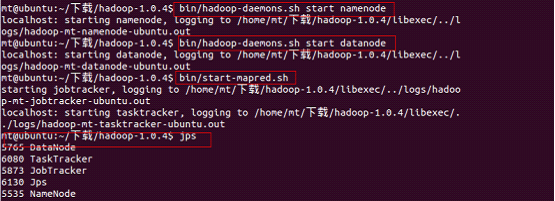

6.啓動hdfs。這裏的datanode jobtracker都在同一主機上運行。啓動時需要注意不是直接運行bin/start-all.sh文件。而是按以下順序來運行。引文在單個注意上運行時datanode namenode jobtracker tasktracker 等都是在同一主機上運行。但是在運行時候有一定的依賴關係。所以需要按順序啓動。執行情況如下圖:

圖-啓動流程 查看啓動情況

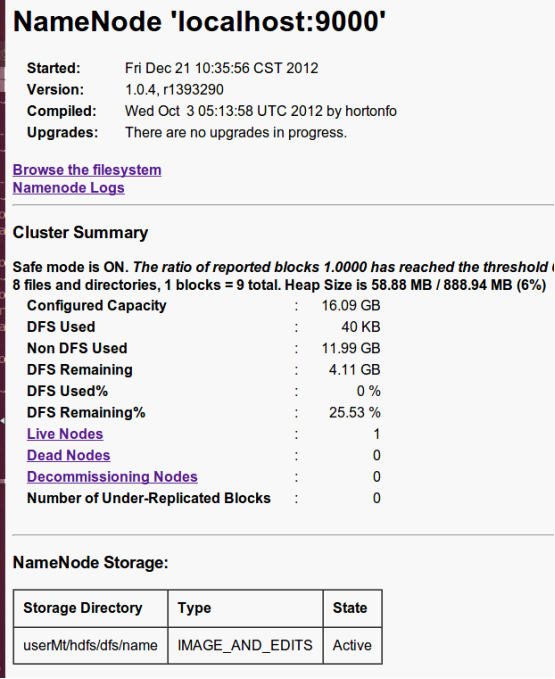

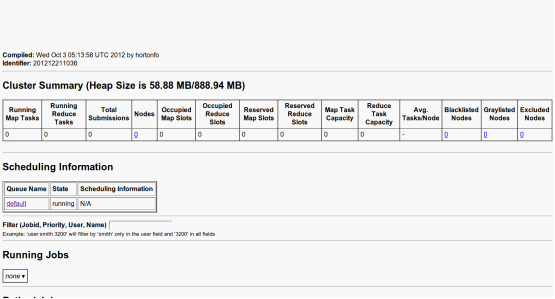

到現在爲止,hadoop已經成功啓動,所有節點都並運行在本機上。如果需要查看namenode的狀況可以訪問 www.localhost:50070。查看map/reduce的狀況訪問 www.localhost:50030。信息如下:

圖-namenode信息

圖-map/reduce信息

5 hbase安裝

1.版本在上面已經提到,這裏直接將下載的壓縮文件解壓到自定義目錄。我是解壓的“下載”目錄

2.對解壓的文件進行配置。打開con/目錄。編輯hbase-env.sh,進行java_home的配置。

圖-hbase java_home配置

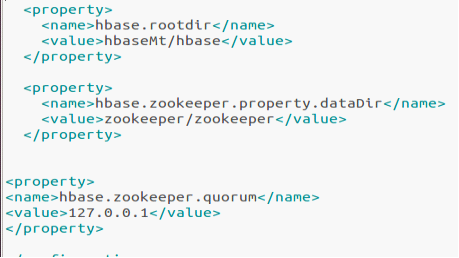

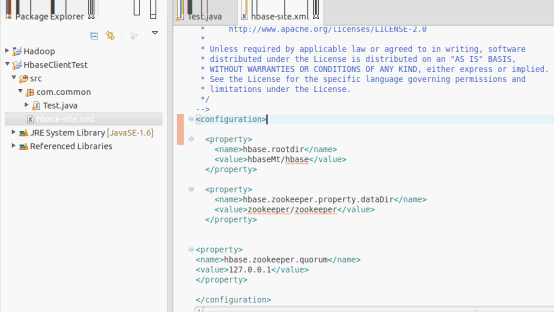

3.編輯hbase-site.xml文件。定義hbase和zookeeper(可靠協調系統,提供的功能包括:配置維護、名字服務、分佈式同步、組服務等)的文件存儲目錄。以及zookeeper的主機節點

圖-hbase hbase-site.xml

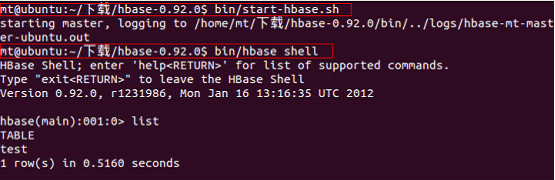

4.啓動hbase,並進入建表模式。

圖-base啓動

6 在eclipse下進行簡單的測試

1.新建立java工程

2.將hbase解壓文件下的conf/目錄中的hbase-site.xml拷貝到eclipse的src根目錄下。

圖- eclipse配置文件

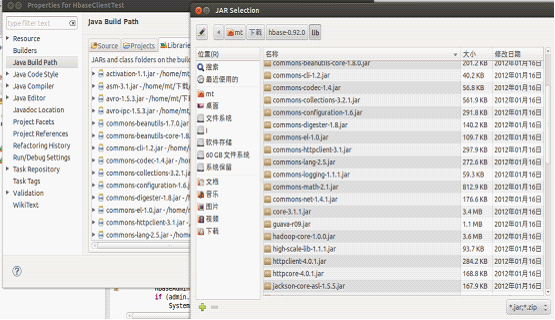

3.進入eclipse點擊添加額外的jar包選項。將hbase根目錄下的兩個jar包和lib/文件夾下的jar包全部引入。

圖-添加jar包到工程中

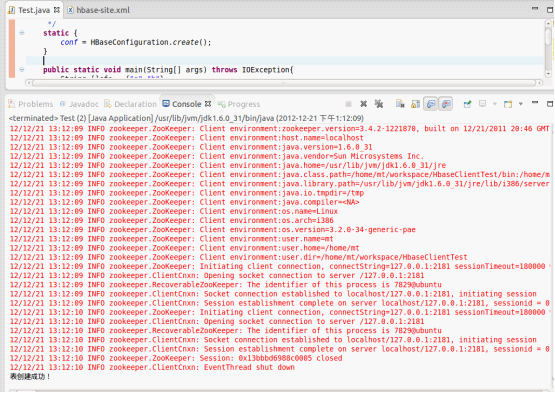

4.編寫測試類進行測試。測試結果如下圖:

圖-運行結果