Acunetix Web Vulnarability Scanner V10.5 詳細中文手冊

注:文本由U神原創,轉載請註明作者和出處。

目錄:

0×00、什麼是Acunetix Web Vulnarability Scanner ( What is AWVS?)

0×01、AWVS安裝過程、主要文件介紹、界面簡介、主要操作區域簡介(Install AWVS and GUI Description)

0×02、AWVS的菜單欄、工具欄簡介(AWVS menu bar & tools bar)

0×03、 開始一次新掃描之掃描類型、掃描參數詳解(Scan Settings、Scanning Profiles)

0×04、AWVS的應用程序配置詳解(Application Settings)

0×05、AWVS的蜘蛛爬行功能(Site Crawler)

0×06、AWVS的目標探測工具(Target Finder)

0×07、AWVS的子域名探測工具(Subdomain Scanner)

0×08、AWVS的SQL盲注測試工具(Blind SQL Injection)

0×09、AWVS的HTTP請求編輯器(HTTP Editor)

0×10、AWVS的HTTP嗅探工具(HTTP Sniffer)

0×11、AWVS的HTTP模糊測試工具(HTTP Fuzzer)

0×12、AWVS的認證測試工具(Authentication Tester)

0×13、AWVS的WEB WSDL掃描測試工具(Web Services Scanner、Web Services Editor)

0×00、什麼是Acunetix Web Vulnarability Scanner

Acunetix Web Vulnerability Scanner(簡稱AWVS)是一款知名的Web網絡漏洞掃描工具,它通過網絡爬蟲測試你的網站安全,檢測流行安全漏洞。它包含有收費和免費兩種版本,AWVS官方網站是:http://www.acunetix.com/,目前最新版是V10.5版本,官方下載地址:https://www.acunetix.com/vulnerability-scanner/download/,官方免費下載的是試用14天的版本。這裏我們以V10.5破解版來講解。

功能以及特點:

a)、自動的客戶端腳本分析器,允許對 Ajax 和 Web 2.0 應用程序進行安全性測試。

b)、業內最先進且深入的 SQL 注入和跨站腳本測試

c)、高級滲透測試工具,例如 HTTP Editor 和 HTTP Fuzzer

d)、可視化宏記錄器幫助您輕鬆測試 web 表格和受密碼保護的區域

e)、支持含有 CAPTHCA 的頁面,單個開始指令和 Two Factor(雙因素)驗證機制

f)、豐富的報告功能,包括 VISA PCI 依從性報告

h)、高速的多線程掃描器輕鬆檢索成千上萬個頁面

i)、智能爬行程序檢測 web 服務器類型和應用程序語言

j)、Acunetix 檢索並分析網站,包括 flash 內容、SOAP 和 AJAX

k)、端口掃描 web 服務器並對在服務器上運行的網絡服務執行安全檢查

l)、可導出網站漏洞文件

0×01、AWVS安裝過程、主要文件介紹、界面簡介、主要操作區域簡介

注:本文提供的破解 方式僅供軟件試用,請於鏈接文字24小時內刪除 ,如需使用請購買正版!

1、下載地址:http://pan.baidu.com/s/1i3Br6ol 提取密碼:u60f 。其中 2016_02_17_00_webvulnscan105.exe是AWVS v10.5的安裝包,而Acunetix_Web_Vulnerability_Scanner_10.x_Consultant_Edition_KeyGen_Hmily 是破解補丁。AWVS安裝的方法與安裝windows程序安裝方法一樣,我們這裏主要講解安裝的主要點:

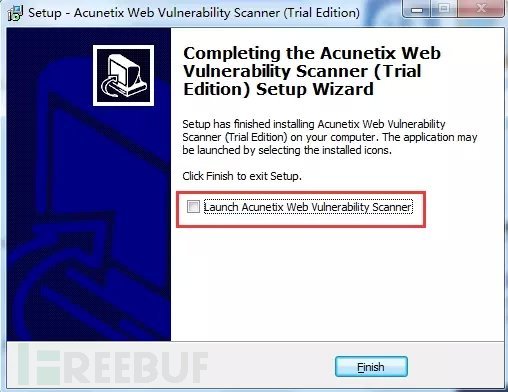

2、安裝到最後一步的時候將“Launch Acunetix Web Vulnerbility Scanner”前的勾去掉,安裝完成之後將會在桌面生成兩個圖標:

3、之後我們將破解補丁移動到AWVS的安裝目錄,打開破解補丁。點擊patch之後便可以完成破解,最後關閉破解補丁。

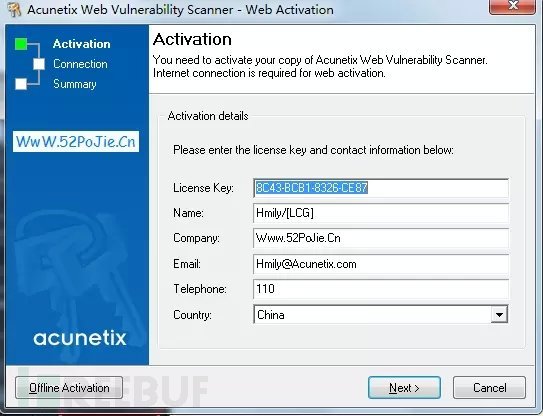

4、破解之後,程序將彈出下面程序,直接點擊next下一步

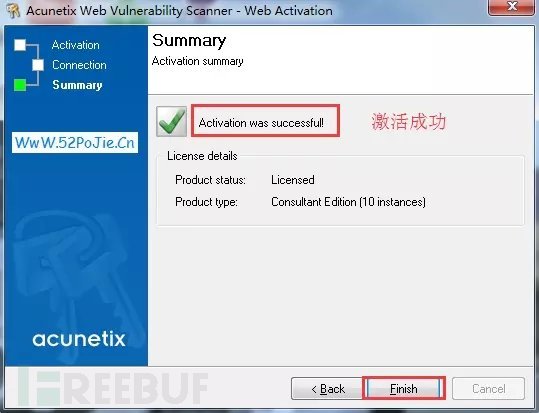

5、最後提示激活成功之後,直接Flish完成安裝,提示Successfuly表示成功安裝。

6、啓動桌面上的Acunetix Web Vulnerability Scanner 10.5,在菜單欄上選擇——Help——About可以看到AWVS的版本,以及包括“Program Updates”可檢查軟件更新,我們這裏就不更新。畢竟我們下的是最新版的。

7、主要程序介紹:在程序安裝路徑“C:\Program Files (x86)\Acunetix\Web Vulnerability Scanner 10” 中主要文件的作用如下:

8、安裝界面介紹:啓動AWVS可以看到整個程序的界面

①、標題欄

②、菜單欄

③、工具欄

④、主要操作區域

⑤、主界面

⑥、狀態區域

9:主要操作區域簡介:

0×02、AWVS的菜單欄、工具欄簡介(AWVS menus bar & tools bar)

a)、菜單欄

File——New——Web Site Scan :新建一次網站掃描

File——New——Web Site Crawl:新建一次網站爬行

File——New——Web Services Scan:新建一個WSDL掃描

Load Scan Results:加載一個掃描結果

Sava Scan Results:保存一個掃描結果

Exit:退出程序

Tools:參考主要操作區域的tools

Configuration——Application Settings:程序設置

Configuration——Scan Settings:掃描設置

Configuration——Scanning Profiles:側重掃描的設置

Help——Check for Updates:檢查更新

Help——Application Directories——Data Directory:數據目錄

Help——Application Directories——User Directory:用戶目錄

Help——Application Directories——Scheduler Sava Directory:計劃任務保存目錄

Help——Schedule Wen Interface:打開WEB形式計劃任務掃描處

Help——Update License:更新AWVS的許可信息

Help——Acunetix Support——User Mannul(html):用戶HTML版手冊

Help——Acunetix Support——User Mannul(PDF):用戶PDF版手冊

Help——Acunetix Support——Acunetix home page:AWVS官網

Help——Acunetix Support——HTTP Status:HTTP狀態碼簡介

b)、工具欄

從左到右分別是(這些都可以在主要操作區域找到,所以不常用):

新建掃描——網站掃描——網站爬行——目標查找——目標探測——子域名掃描——SQL盲注——HTTP編輯——HTTP嗅探——HTTP Fuzzer——認證測試——結果對比——WSDL掃描——WSDL編輯測試——程序設置——掃描設置——側重掃描設置——計劃任務——報告

0×03:一次新的掃描的功能全面概述(Scan Settings:掃描類型、掃描參數)

1、點擊菜單欄的 New Scan 新建一次掃描, 網站掃描開始前,需要設定下面選項:

1). Scan type

2). Options

3). Target

4). Login

5). Finsh

1、Scan type:

①:Scan single website:在Website URL處填入需要掃描的網站網址,如果你想要掃描一個單獨的應用程序,而不是整個網站,可以在填寫網址的地方寫入完整路徑。wvs支持HTTP/HTTPS網站掃描。

②:Scan using saved crawling results:導入WVS內置 site crawler的爬行到的結果,然後對爬行的結果進行漏洞掃描。

③:Access the scheduler interface:如果被掃描的網站構成了一個列表形式(也就是要掃描多個網站的時候),那麼可以使用Acunetix的Scheduler功能完成任務,訪問 http://localhost:8183,掃描後的文件存放在“C:\Users\Public\Documents\Acunetix WVS 10\Saves”.

Acunetix的計劃任務,主要特性如下:

a). 可用於大量掃描,掃描結果保存在“C:\Users\Public\Documents\Acunetix WVS 10\Saves”。

b). 掃描結束,可以使用郵件通知。

c). 可設定計劃時間,什麼時候允許掃描,什麼時候不允許掃描

2、Options:

Scanning options :側重掃描的漏洞類型設置

①:Scanning profile:設置側重掃描的類型,包含16種側重檢測類型,如下:

每種側重掃描的類型又有包含多種掃描script,如果需要做調整或者修改,請查看 Configuration >> Scanning Profiles

Scanning Profiles中的每個側重掃描的類型下都包含了非常多的掃描腳本,由於太多我就不一一介紹,隨便點擊一個,右邊就有對該掃描腳本的介紹,隨意抽選幾個介紹,例如:

ftp_anonymous.script:掃描ftp匿名登錄漏洞 PHPInfo.script:掃描是否有phpinfo泄露

Backup_File.script:掃描網站的備份文件 wordpress_8.script:針對 wordpress弱口令測試

你也可以選擇掃描的腳本,然後新建自己的掃描策略,如下:

選擇自己需要的策略,可以單擊保存按鈕保存一份策略,單擊X按鈕刪除一個策略

Scan Setting:掃描配置

②:可定製掃描器掃描選項,AWVS在默認情況下只有“default”默認掃描參數配置策略,點擊旁邊的Customize則可以自定義:

與界面主操作區域對應:如下

(注意要點:如果在新建嚮導中設置Scan setting只會影響本次掃描的掃描參數設置,如果在主界面中的Scan Setting設置則是全局配置)

此處可以設置各種掃描參數配置,包括點擊白色處“”是新建配置,單擊X則是刪除配置。

a)、Scan options 掃描配置

①:禁用蜘蛛爬行出發現的問題,AWVS在漏洞測試之前會使用蜘蛛功能對網站先進行測試,此處是禁用蜘蛛爬行發現的問題,如:錯誤的鏈接。一般這樣的錯誤都是風險很低的警告信息。

②:scanning mode 是指掃描的模式分爲三種如下:

Heuristic:標準的掃描模式,掃描線程和深度一致

Quick:快速掃描模式

Extensive:擴展性掃描,完整掃描模式

它們三種模式的掃描線程、深度如下:

③:目錄爬行的遞歸深度,默認爲5級,使用0則關閉

不要發出超過500個相同類型的警告,使用0則關閉

④:開啓目標端口掃描功能,但該掃描速度較慢,建議使用NMAP端口掃描

⑤:收集不常見的HTTP請求狀態,例如HTTP 500狀態碼

⑥:在掃描過程中如果服務器停止響應嘗試25次之後中止掃描

⑦:在掃描過程中,是否使用網站設定的cookie

⑧:網站中鏈接到其它主機的文件,而這些網站與主站的關係相近,例如:www.baidu.com 鏈接中包含test.baidu.com,你可以在這裏添加允許與主站關係很大的域名來進行掃描,可以使用通配符形式。這樣掃描的時候將掃描這些主機的漏洞。

b)、Headers and Cookies 頭部與Cookie

(a)、Test cookies for all files (by default it will only check files with parameters)

訪問所有文件,都使用cookie測試(默認情況下,只有帶參數的文件才使用cookie進行檢測)。

(b)、Manipulate the HTTP headers listed below

操控HTTP頭部信息,可按照自己的要求定製HTTP頭。

(c)、Add Header

添加一個HTTP頭部,在新增的“enter header name here”單擊此處可以輸入你的頭部名稱。

(d)、Remove Selected

移除你選中的HTTP頭部

c)、Parameter Exclusion 掃描參數排除

有些參數不影響用戶會話的操作,你可以排除這些參數被放在這個名單中,掃描器將不會去掃描測試這些參數,注意:名稱應該爲正則表達式

(a)、添加一個參數排除:

包含URL(*代表任何URL)、名字(要過濾的參數,一般以正則表達式表示)、type(請求方式,包含Any任何類型、GET、POST類型、COOKIE類型)

(b)、移除選中的排除

d)、GHDB 利用Google hacking數據庫檢測

Google hacking數據庫設置,包含了1467條數據在數據庫中

AWVS在掃描的過程中利用google hacking技術在google搜索引擎上對目標網站進行信息蒐集。下面的語法是對網站的信息搜索的google語法。

(a)、Short description: 簡要描述信息:(參考:http://baike.baidu.com/view/336231.htm )

(b)、Query String :Google上查詢的字符

(c)、 Filter GHDB:GHDB過濾搜索 (Short description:簡要描述 Query String 查詢字符串 Full description:所有描述)

(d)、check visible:檢測明顯的 unchek visible:不檢測明顯的 check only visible:檢測僅明顯的

③: Crawling options 爬行設置:

針對特定的掃描場景,自定義爬蟲的行爲,這些選項將定義爬蟲的行爲:

start HTTP Sniffer for manual crawling at the end of process:蜘蛛爬行過程結束後啓動HTTP嗅探,以發行更多鏈接。

Get first URL only:只掃描首頁,不抓取任何鏈接。

Do not fetch anyting above start folder:不掃描上級目錄,例如:新建掃描爲http://www.baidu.com/cms/,將不會掃描cms上級目錄的鏈接。

Fetch files below base folder:掃描子目錄。

Fetch directory indexes even if not linked:獲取目錄索引,即使沒有關聯性的。

Retrieve and process robots.txt, sitemap.xml. :抓取並分析robots.txt、sitemap.xml中出現的目錄、URL。

lgnore CASE differences in paths:忽略目錄的大小寫敏感

fetch default index files (index.php,default.asp):嘗試獲取每個目錄下的默認索引文件,例如掃描http://qq.com,如果爬行到test目錄則嘗試獲取test目錄下是否有索引文件,例如:http://qq.c/test/index.php 。

try to prevent infinite derectory recursion:防止抓取到死循環的無限目錄。如:http://qq.com/admin/admin/admin/admin/admin

crawl should request only linked files: 爬行應請求只有關聯性的文件。

ignore parameters on file extensions like .js .css…etc:忽略文件擴展名類似爲js css的參數。

disable auto custom 404 detection(application will use only user defined reles):禁用自動定製404檢測(應用程序將使用用戶定義的規則)。

consider www.domain.com and domain.com as the same host:如果啓用該項那麼AWVS會認爲www域名和頂級域名是同一主機。

enable input limitaion heuristics:如果啓用該選項,並在同一目錄下的文件被檢測20多個相同的輸入方案,抓取工具只會抓取前20個相同的輸入方案。

optimize inputs for known applications: 對已知應用程序輸入的優化。

maximum num ber of variations:變化的最大數目,例如:http://www.baidu.com/index.php?id=1,這裏設置ID的最大值爲50。link depth limitation:鏈接深度限制,例如從A站點抓取發現了一個鏈接,又從該鏈接上發現另一個鏈接,以此類推最大深度默認爲100。

structure depth limitation:子目錄的最大深度的限制,默認最大15級目錄。

maximun number of files in a derectory:在一個目錄下AWVS爬取文件數量的最大值。

maximum number of path schemes:判斷路徑任務的最大任務數。

crawler file limit:爬蟲爬行文件的數量限制。

④:file extension filters: 文件擴展名過濾

AWVS將讀取該配置,嘗試掃描哪些後綴的文件,例如排除掉的後綴文件,AWVS在工作的時候將不掃描被排除的後綴文件,因爲掃描它們毫無意義。

a)、包含的擴展名,AWVS將會掃描的後綴擴展文件

b)、 排除的擴展名,AWVS將不掃描的後綴擴展文件

⑤: Directory and file filters:目錄和文件過濾

定義一個目錄列表被排除在爬行和掃描過程通配符允許您篩選一系列文件:如/dir1/* 或者/dir1/a *。表示將不掃描/dir1/下的文件,/dir1/a*表示的是不掃描dir1下以a開頭的文件的漏洞。

a)、過濾的URL

b)、是否爲正則表達式

⑥:URL Rewrite:URL重定向設置

一些網站使用URL重寫,這裏你可以定義一個列表的URL重定向不同網站幫助爬蟲瀏覽這些網站。

⑦:HTTP Options

定義在爬行和掃描過程的HTTP頭選項

(a)、用戶當前的agent

(b)、定義不同瀏覽器的agent

(c)、檢查最大的併發連接數

(d)、HTTP的請求超時時間

(e)、AWVS對兩個請求之間延遲的毫秒,某些WAF對訪問請求時間太快會進行攔截

(f)、HTTP請求的文件字節大小限制,默認5120kb

(h)、自定義HTTP 頭部,例如自定義IP報頭或者其它的HTTP頭,如下:

⑧:Lan Settings

配置代理服務器來掃描網站漏洞

a)、http代理服務器

b)、Socks代理服務器

⑨:DeepScan

深度掃描,深度掃描技術,嵌入WebKit提供使用JavaScript基礎技術如AJAX / HTML5和SPA 網站全面支持

a)、啓用深度掃描

b)、掃描從外部引入的腳本中存在的漏洞,例如scr=http://www.qq.com/xx.jsp

c)、Session 超時的秒數

⑩:Custom Cookie

自定義Cookie,例如你在網站的登錄之後獲取Cookie,將Cookie添加到這來就可以實現預登陸狀態下的掃描

a)、添加、移除自定義的cookie ,包含要添加的URL,使用*表示所有的URL,以及對應的Cookie值。

b)、掃描時鎖定自定義的cookie

⑾:Input Fileds

此處主要設置提交表單時的字段對應的默認值,例如在HTML表單提交中出現age的字段,則會自動填寫值爲20。字段中:*web*中的是含有通配符的表示形式,例如1web2這樣的就是滿足*web*,而字段的值則有多種變量如下:

${alpharand}:a-z的隨機字符串

${numrand}:0-9隨機數字

${alphanumrand}:上兩個的組合(隨機字符串+隨機數字)

(a)、從URL中 解析表單的字段,例如輸入http://login.taobao.com 將從這裏讀取表單的字段,值如果有默認則填寫默認,沒有則需要自己添加,例如對wooyun.org自動提取表單的字段,預設值則需要自己設置,這樣方便在掃描的時候AWVS自動填寫預設的值去提交表單進行漏洞測試

(b)、添加、移除、前後順序設置自定義的表單字段,包含:名字、值、長度

⑿ : AcuSensor

傳感器技術 ,從這個節點,您可以啓用或禁用acusensor和它的功能和設置密碼。

(a)、啓動AcuSensor技術

(b)、爲AcuSensor設置密碼

(c)、請求文件列表

(d)、開啓服務器警告

(e)、在一個特定的URL上測試AcuSensor

⒀:Port Scanner

配置端口掃描程序的、socket、超時和端口設置

(a)、用戶掃描端口的線程數

(b)、連接超時的毫秒時間設置

(c)、添加、移除掃描的端口,這裏已經列舉了常用的端口,AWVS將會掃描這裏的端口。

⒂:Custom 404

自定義404頁面,爲了掃描中防止誤報,應當自定義404頁面

自定404頁面的方式:

①:自定義404的URL

②:404頁面的關鍵字匹配

③:匹配的關鍵字出現的位置

Location header:出現在HTTP頭部

Result body:出現在HTTP的正文處

Result headers:出現在HTTP的頭部+正文處

④:測試404頁面是否存在Pattern中輸入的,如果成功表示404頁面中存在該關鍵字

⑤:是否爲正則表達式

當然你可以單擊向下展開的按鈕,可以測試網站的404頁面包括頭部、瀏覽形式的查看,然後你可以選擇404的關鍵字,通過點擊“Generate pattern from selection”來生成404的關鍵字或者表達式,並且會自動設置出現的位置。

Adjust advanced scan setting:

在掃描嚮導中顯示高級掃描設置,如下面的Advanced就是高級選項

Advanced:

進入高級之後分別是:

①:在爬行結果之後選擇我們需要掃描哪些文件

②:自定義從哪裏開始掃描,導入txt文件,例如掃描http://www.baidu.com,不想從根路徑開始掃,而從二級目錄http://www.baidu.com/test/,將其保存到txt文件中之後將從test二級目錄開始掃描

③:爬行的時候使用外部測試工具,蜘蛛爬行的過程中將運行您設置的命令,以及超時時間設置

④:設置包含一個火狐擴展插件Selenium IDE生成的HTML文件,蜘蛛爬行的過程中將會根據它來進行爬行。

Target:

(a)、掃描目標的根路徑

(b)、服務的banner

(c)、目標URL

(d)、目標操作系統

(e)、目標的Web容器

(f)、目標的程序語言

Login:

①:使用預先設置的登錄序列,可以直接加載lsr文件,也可以點擊白色處開始按照步驟新建一個登錄序列(具體步驟參考後面的演示)

②:填寫用戶名密碼,嘗試自動登錄.在某些情況下,可以自動識別網站的驗證。

Finish:

①:使用AcuSensor傳感技術的設置

②:爬行與掃描中是否區分大小寫

③:將這次的設置保存爲一個策略,以便下次直接使用策略

開始掃描:

①:

依次爲:

#1、Generater report from this scan :

使用Configuration Settings可定製報告的某些信息,例如logo等.

轉換爲不同的格式報告:

②:掃描結果顯示,包含存在漏洞的名字、鏈接、參數等,Site Structrus是網站爬行出的結構狀態、Cookie是爬行的Cookie信息。

③:詳情信息顯示,需要點擊左邊的掃描結果纔會展示詳情信息。如下圖就是左側顯示的SQL注入和參數,右邊是SQL注入的詳情。

如果不點擊則是掃描的高低危漏洞統計,如下圖就是威脅等級:Level 3,漏洞總結果是17個,High(紅色):高危漏洞2個,Medium(橙色):中危漏洞8個,Low(藍色):低危漏洞5個,Informational(綠色):提示信息2個。

④ :顯示三個信息。

Taget Information:包含目標站點 1、是否應答、2、WebServer的banner、3、操作系統、4、Web容器、5、程序語言

Statistics:對掃描的各種信息統計,包含1、掃描的總時間、2、HTTP請求數量、3、平均掃描時間、4、掃描重複次數

Progress:掃描進度信息的提示,包含1、是否掃描完成,100.00%表示已完成,2、端口掃描是否完成 3、蜘蛛爬行是否完成(文件數量、目錄數量、變量數量)、4、腳本信息 5、內部模塊

⑤ 顯示應用程序運行、測試的日誌、錯誤日誌。

0×04、AWVS的應用程序配置詳解

三個設置點:

1、Application Settings:

1、Application Updates: 程序升級的配置

Application Updates:程序升級

①:程序更新,分爲兩種:

At application startup:在程序啓動時自動檢查更新

When ‘check for updates’ is clicked:用戶點擊“General——Program Updates——Check for updates”時更新

②: 更新時使用代理服務器來更新程序,需填寫主機名、代理端口、用戶名和密碼

2、Logging: 日誌配置

①:Enable logging:開啓日誌功能

②:Log infomational messages:將程序的提示信息記入日誌

③:Log warning messages:將程序的警告信息記入日誌

④:Log Errir messages:將程序的錯誤信息記入日誌

⑤:Log HTTP request and response to a file:將程序中發起的HTTP請求和響應信息記錄到一個文件中log\httplog.txt

⑥:Log only HTTP error in HTTP log:只記錄HTTP的錯誤信息在HTTP的日誌中

⑦:Include timestamps:在記錄日誌的時候包含產生每條記錄的時間戳

⑧:On error switch to Error Log tab:在發生錯誤信息的時候,自動切換到Error Log面板

⑨:number log files to keep before deleting:刪除日誌前需要保留的日誌數量,默認2個

3、Saved Scan Results 掃描保存數據庫的設置

①:保存報告的數據庫類型:分爲: MS Access 和 MS SQLSERVER兩種,如果使用SQLserver將要填寫SQLServer的數據庫地址、用戶名、密碼包括數據庫名等。

②:Access數據庫的保存位置,默認是:C:\ProgramData\Acunetix WVS 10\Data\Database\vulnscanresults.mdb

③:如果你使用SQLServer數據庫,不想填寫數據庫IP\用戶名\密碼\數據庫名等信息,你可以直接導入.dbconfig格式的數據庫配置

④:掃描完成之後自動保存結果。

4 、HTTP Authentication HTTP基本驗證

此驗證主要用於如下類似的HTTP基本認證:

①:AWVS在掃描過程中可識別基本驗證,在此過程中不要詢問我們是否需要驗證,選中此項AWVS將不會提示我們哪些頁面需要認證。

②:自動保存憑證信息,在AWVS掃描過程中詢問我們HTTP認證的賬號密碼,勾選此項之後,當我們輸入用戶名密碼之後,AWVS將自動保存我們的輸入,以便以後掃描時不再需要輸入。

③:配置需要驗證的 Host主機、路徑Path、Username用戶名和Password密碼。

按鈕中:

Add Credentials:添加一個憑證

Remove Selected:刪除選擇的憑證

Edit:編輯選中的憑證

Show Password:顯示已添加的憑證的密碼

5、Client Certificates: 證書驗證

①:Certificate file:選擇證書文件 Password:證書密碼 URL:驗證證書的URL地址

②:Import Certificate:上方填寫完整之後點擊此按鈕導入證書 Remove selected:移除選中的證書

6、Login Sequence Manager:表單驗證 【重點】

表單驗證用戶某些頁面,例如掃描後臺、掃描用戶登錄後可訪問的頁面時候,需要登錄用戶密碼驗證再進行掃描

與新建掃描嚮導中的“Login”功能一致,需要新建一個表單驗證。

①:New sequence :新建一個表單驗證 Edit sequence:編輯一個表單驗證 Remove sequence:移除選中的驗證

Browser:瀏覽表單驗證文件,後綴爲.lsr。

如何新建一個表單驗證,過程三個步驟如下,以DVWA滲透測試演練系統來演示:

#1、Record Login Actions 記錄登錄操作,這一步是選擇需要登錄的頁面之後,輸入賬號密碼進行登錄,然後程序將會記錄登錄的所有操作、包括輸入的賬號密碼以及登陸後跳轉的頁面

①:此處標記的是你掃描的URL

②:此處當然你登錄的表單區域了

③:三個按鈕 Record :開始記錄登錄的操作 Stop:停止記錄登錄操作 Play:回放你錄製的登錄操作來確定是否正確

⑤:這裏記錄的是你的幾個動作,如上圖只有三個動作:

1、導航到http://127.0.0.1/dvwa/login.php

2、對錶單的username字段輸入admin賬號

3、對錶單的password字段輸入password密碼

4、雖然上圖沒有第四步,但是第四步是:Clik on Login,就是我們點擊登錄的這個步驟

④: ↓ ↑:上下鍵來調整登錄的步驟 ,+ 、- :增加或刪除一個登錄步驟

⑥:顯示登錄每個步驟的類型、目標、超時時間、填入的值

第一步記錄登錄操作已經成功完成,點擊Next進入下一步

#2、Record Restrictions:記錄限制請求,此處的記錄的原因是如果AWVS在掃描登錄狀態的頁面的時候,如果請求到類似Logout的退出請求,那麼就會結束會話並退出登錄,這樣下來我們就無法繼續掃描後臺的漏洞了,所以此時我們需要記錄一個限制的地址,也就是告訴AWVS,哪個請求是會退出會話,當然不僅僅是退出,如果一個後臺有“註銷”、“退出”、“重新登錄”三個按鈕,我們也要同時記錄着三個請求。

針對DVWA的限制請求記錄步驟

①:首先Restrict按鈕是要呈現按下的狀態,此時就會開始記錄用戶點擊的限制請求

②:DVWA中的左側導航“Logout”是退出的鏈接,我們點擊它之後中間會彈出一個攔截

③:攔截中的數據就是我們點擊“Logout”的請求,這裏有三個按鈕

Restrict request using exact match :記錄下此請求標識爲精確的限制約束,也就是說將它告訴AWVS不要請求該鏈接

Forward :放過這個請求,不標記它爲限制請求

Forward all:停止抓取所有請求,釋放所有的請求

所以這裏我們選擇:第一個按鈕,標記 http://127.0.0.1/dvwa/logout.php ;爲限制請求,不讓AWVS去請求它。

如上圖:停止抓取請求,點擊“Restrict”使這個按鈕呈未按下狀態,然後可以看到右上角出現的限制約束的請求鏈接,OK,Next進入下一步了。看到successfully,我想你已經知道這步是成功確定了一種檢測有效會話的模式。

#3、檢測會話是否有效:完成第二部步驟之後進入第三步驟是檢測我們的會話是否有效,如果有效就完成了一次表單登錄驗證的流程。

②:Detect while navigating:導航檢測,選中進入進入下一步

①:隨意點擊一個需要登錄鏈接,如果彈出Successfully則說明我們去點擊這個鏈接的會話是正確的,

③:歷史檢測:獲取歷史檢測的正確性

⑤:這裏會自動獲取登錄狀態之後的關鍵字或狀態碼,並以一種方式判斷,這裏分別有幾種方法:

a)、檢測到登錄後的的狀態碼是多少,或者不是多少?

status code is

status code is not

b)、檢測登錄後的關鍵字是在頭部、還是不在頭部?

Pattern is found in headers

Pattern is not found in headers

c)、檢測登錄後的關鍵字是否在返回的響應中?

Pattern is found in response

Pattern is not found in response

④:Check Pattern:測試AWVS提取的關鍵字是否正確,如果是successfully則表示正確

⑥:完成登錄表單驗證的步驟之後保存會話文件,後綴爲.lsr

最後AWVS可以正常掃描登錄狀態後的頁面的漏洞了:

7、False Positives 處理誤報

此處是存儲誤報的鏈接、請求的。在我們掃描的結果中,如果你認爲這一項是AWVS的誤報,右擊選擇它”Mark alert(s) as false positive“將它放置到誤報區域內,AWVS下次掃該站點的時候將不會再認爲它是一個漏洞。Removed Selected則是移除選中的誤報。

8、HTTP Sniffer 代理型嗅探抓包設置

Acunetix HTTP 代理設置,默認監聽8080端口(此功能默認不開啓)

①:監聽的接口分爲兩種:

local interface (recommended):接受本機的代理請求(推薦)

all interface (not recommended) 接受所有的代理請求(不推薦)

②:監聽的端口,默認是8080

此配置設置之後點擊“Apply”應用之後,在主操作區域的Tools中選擇HTTP Sniffer,將本地瀏覽器設置代理爲127.0.0.1:8080,再點擊“Start”就可以獲取嗅探到訪問網頁的數據包了

9、Scheduler:計劃任務性掃描

用戶可以不啓動AWVS來掃描漏洞,可以直接訪問Web版實現計劃任務,可以掃描多個網站漏洞,使用該項服時要保證Acunetix WVS Scheduler v10服務已經啓動。

Web Interface:Web版掃描的配置

Listen open port:Web界面計劃任務的端口,訪問:http://localthost:8183

Allow remote computers to connect:允許遠程計算機訪問我們的Web版的計劃掃描頁面,如果一旦開啓則強制使用HTTPS協議另外還需要設置賬戶密碼來進行驗證,爲了保證它的安全性。

Use HTTPS:使用HTTSP協議加密傳輸的數據

Require authentication:使用用戶名、密碼形式驗證,一般配合“Allow remote computers to connect”來使用。

Change administrative password:修改認證的用戶名密碼

Scan:設置計劃任務掃描的線程與保存結果

Scan results save folder:Web任務計劃掃描結果的保存位置

Parallel scans (max 10):同時掃描的網站的數量,最多10,如果你的許可證書是正版,最大數量可達到500個

Email Notifications:配置郵件服務器將掃描工作通過郵件形式發送給您

Send email notifications when scans are fnished:選擇是否掃描工作的時候發送郵件通知我們,如果勾選則啓用該功能

Server ip/hostname:郵件系統的主機IP

Port:郵件系統的端口

The SMTP server requires authentication:勾選它SMTP服務器是否需要密碼認證

Username:SMTP用戶名

Password:認證密碼

TT:郵件發送的目標,郵件將發送給誰。

CC:郵件將抄送給誰

From:發送的人的設置,就是說郵件是從哪個郵箱發送的

Check here to verify Settings:測試郵箱是否正確配置,是否能成功發送

Excluded hours Templates:禁止掃描時間設置模版

在長時間掃描的時候,假如你不想在流量高峯期掃描你的網站,你可以指定一個暫停掃描的時間範圍。例如上圖:紅色區域表示不允許掃描的時間,藍色區域表示掃描的時間,這裏表示週六、週日早上4:00-4:59之間的時候不進行掃描。

10、Miscellaneous 雜七雜八項配置

Memory Optimization:內存優化

Use temporary files to reduce memory usage:使用臨時文件,掃描中產生的臨時文件存儲在硬盤中,而不存儲在內存中,以減少內存的使用情況。

Tamporary folder:臨時文件的位置

Keep all AcuSensor data in memory fo inspection:保持所有的AcuSensor數據在內存中檢測

Maximum memory during crawling:爬行過程中可佔用的最大內存(單位:M),如果在爬行和掃描過程中內存不足,則自動停止掃描

Display Options:顯示選項

Display custom HTTP status information:顯示自定義HTTP狀態信息

Display HTTPS status icon:顯示HTTPS的狀態圖標,啓用此選項的話,掃描的時候,如果發現https訪問的區域,將會在爬行結果中顯示出一個鎖狀的小圖標

Password Protection:密碼保護

Current password:當前密碼

New password:新密碼

Confirm new password:確認新密碼

Set password:設置密碼

設置密碼的方式是,當前如果爲空密碼,直接在第二三個文本框輸入密碼,點擊Set password就可以完成密碼設置, 配置密碼後,運行wvs主程序及主要程序時需要輸入口令驗證 。

如果需要清除設置的密碼,只要輸入當前密碼,新密碼處留空再點擊設置密碼即可。

0×05:AWVS的蜘蛛爬行功能:

作用:爬行網站所有URL,可瞭解網站基本目錄結構,以便於進行下一步的掃描

①:Tools–Site Crawler 選擇網站爬行功能

②:從左到右的功能分別爲:

:打開格式爲.cwl的蜘蛛爬行的結果

:保存格式爲.cwl的蜘蛛爬行結果

:導出 export.xml蜘蛛爬行報告

: 從導入的文件建立結構

:掃描這個網站的漏洞

:選擇一個文件進行掃描

③:被爬行網站的登錄驗證文件,加載這個文件可以爬行到需要登錄的頁面資源。Strart:開始爬行 Stop:停止爬行

④:被爬行網站的的爬行結果:

Name:爬行網站的的文件名稱、Cookiie信息

HTTP Result:文件訪問的狀態,OK表示200,Forbidden表示403,Internal Server Error表示500

Inputs:可輸入的參數值

Title:文件的標題

Content Type:文件的類型

⑤:詳細信息顯示區域,點擊左邊的任意文件,在這裏可以顯示它的詳細信息。下方的選項卡分別爲:

Info:文件詳細信息

Referres:來源頁信息

HTTP Header:HTTP頭部信息

Inputs:可輸入參數的信息

View Source:查看文件源代碼

View Page:以瀏覽方式查看頁面

Structure Analysis:結構分析

0×06:AWVS的目標探測工具(Target Finder)

相當於一款加強版(針對WEB滲透測試)的端口、banner探測工具

功能:

1、探測指定IP/IP段開放特定端口的IP

2、探測出IP後,探測該端口的banner信息,可探測出該端口上運行的WEB服務的中間件的版本信息

①:Tools——Target Finder打開該工具

②:被掃描的IP/IP段,IP段格式爲:192.168.199.1-255,

③:被掃描的端口,這裏是80,443端口

④:掃描出的結果包含: Server:目標主機 Hostname:主機名 Bnaner:Bnaner信息 Web Server:Web容器

⑤:將掃描的結果進行操作分別如下操作:

Scan this Server:用AWVS掃描這臺主機的漏洞

Edit with HTTP Editor:用HTTP Editor測試目標

Save list of targets (for scanning):保存爲.txr格式的目標列表作爲後期的掃描目標

Export list of servers to CSV:導出爲CSV格式的列表,包含所有的描述信息

⑥:查看目標主機的Response Headers(響應的HTTP頭信息)、Response Data(響應的數據)、View Page(瀏覽形式查看)

0×07:AWVS的子域名探測工具(Subdomain Scanner)

作用:探測並猜解子域名的信息,

①: Tools——Subdomain Scanner 工具位置

②: 填寫需要被掃描子域名的主機域名

③: 使用的DNS服務器,分爲兩種:

Use DNS Server from target:使用目標的DNS服務器探測解析

Use Specified DNS Server:使用自定義的DNS服務器,在旁邊可以填寫自定義的DNS服務器

④:Timout:超時時間,單位是秒

⑤:被探測出的子域名列表信息,分別包含Domain:被探測出的子域名; IP Address:子域名對應的IP; Web Server Banner(HTTP):HTTP的WEB服務器的Banner信息; Web Server Banner(HTTPS):HTTPS的WEB服務器的Banner信息

⑥:右擊任意一個探測出的子域名,可對其如下操作:

Scan this Server:用AWVS掃描這臺主機的漏洞

Edit with HTTP Editor:用HTTP Editor測試目標

Save list of targets (for scanning):保存爲.txr格式的目標列表作爲後期的掃描目標

Export list of servers to CSV:導出爲CSV格式的列表,包含所有的描述信息

⑦:分爲HTTP和HTTPS兩種,各自均可查看目標主機的Response Headers(響應的HTTP頭信息)、Response Data(響應的數據)、View Page(瀏覽形式查看)

0×08:AWVS的SQL盲注測試工具(Blind SQL Injection)

作用:在掃描網站的時候,發現網站存在SQL盲注漏洞,你可以倒入到SQL盲注工具中,你也可以直接將抓取的SQL盲注HTTP數據包粘貼到SQL盲注工具中進行注入測試。

HTTP Request:

①:Tools——Blind SQL Injection 工具位置

②:SQL盲注的工具欄,分別作用如下:

:開始執行測試SQL注入

:開始讀取數據庫

:獲取表字段信息

:讀取數據記錄信息

:暫停操作

:中止操作

:新建一個SQL注入

:將當前進行注入的信息保存爲.bln的文件

:打開.bln格式的文件進行注入分析

:導出xml格式的數據庫結構信息

:保存.CVS的數據記錄信息

:顯示或隱藏HTTP Request界面

③:Default Value:SQL注入參數原來的值,這裏/example1.php?name=root 原來的值是root

:添加一個注入的位置,被添加的地方會顯示爲:${injecthere}

④:SQL盲注的HTTP信息,可以在掃描網站得到SQL注入的時候,右鍵“Export to Blind SQL Injection ” ,也可以直接將存在盲注的HTTP請求信息粘貼進來

⑤:搜索區域。

:搜索的結果進行高亮顯示

:搜索的關鍵字爲正則表達式

:搜索的關鍵字匹配大小寫

⑥:此處顯示當前的數據庫的名字、用戶名、版本,以及可列出數據庫、表、字段、數據記錄 ,如下圖右擊一個數據庫可以獲取表、右擊表可以獲取字段、右擊表可以獲取數據。Export the structure to file:將數據結構導出爲.xml的文件

⑦:此處顯示的是注出的所有數據記錄,最下方一行顯示的是信息狀態。

Settings——General:

①:設置數據庫的類型,包括三種類型:Autodetect(自動檢測)、Mysql(Mysql數據庫)、MSSQL(Mssql數據庫)

②:數據庫注入的方法,包括三種類型:Autodetect(自動檢測)、condition based(根據條件情況而定)、Union select base(基於聯合查詢)

③:Show debug information:顯示過程的調試信息

④:對SQL語句中的空格以/**/進行編碼

⑤:強制對HTTP傳輸的SQL字符串進行編碼,勾選此項下面兩項就是設定編碼方式

⑥:對所有的字符進行編碼

⑦:對空格使用+進行編碼

Settings——Condition Based Extractor:

①:SQL注入字符串的設置

Automatic detection:自動檢測

Provided by user:用戶自定義選擇,條件是${},例如:1 and {condition}/*

②:真假條件識別器

Automatic detection:自動檢測

Provided by Regex:指定正則表達式

Inverse Regex:當你想要真實的情況觸發上述正則表達式的條件爲假時,啓用此選項。

③:特徵提取

Bit Method:位測試方法,直接數值轉換數字爲測試

Half Method:則應用程序將嘗試通過使用一半法找出字符的數值,以此遞歸

Try Parallel request:嘗試平行請求

Settings——Union Select based extractor

①:指定聯合查詢中起始的字段數

②:指定聯合查詢中最大的字段數

③:指定可見的索引,0是自動檢測

Tools:

①:通過load_file函數讀取文件內容,需要root權限,點擊“Extract”開始讀取

File Name:被讀取的文件

Offset:指定要從第幾個字符開始讀取

Length:指定讀取多長的字符,0爲讀取全部

②:執行SQL查詢語句,點擊“Excute”進行查詢。

SQL query:要查詢的SQL語句

Offset:指定從第幾個字符開始顯示結果

Length:指定查詢出顯示結果的長度,0是全部

③:執行了上面兩個操作,如果完成之後將會把結果保存在datebasde目錄下,上圖就是報錯的讀取文件和sql查詢的結果。

0×09、AWVS的HTTP請求編輯器(HTTP Editor)

作用:包含兩種模式,一種Request、一種Text Only模式,主要用於編輯HTTP信息,修改HTTP信息併發送給服務器獲取返回的結果,是HTTP信息的重放過程。可修改HTTP的頭部數據或者其它信息再提交給服務器處理等。

HTTP Request模式:

①:Tools——HTTP Editor 工具的位置

②:Start:將當前編輯的HTTP請求提交給服務器處理,並獲取返回結果。 Encoder Tool是編碼工具,界面如下:

支持:URL、HTML、Base64、C-style、MD5、MD4、SHA1、UTF-7等多種編碼解碼方式

③:從左到右的圖標功能分別爲:

:刪去選擇的HTTP頭

:編輯Cookie信息,包括增加、刪除Cookie某個變量

:使用HTTPS協議

Method:請求的方式,分爲GET、HEAD、POST等

Protocol:HTTP的協議分別爲1.0、1.1

URL:HTTP的URI部分

Edit Request Variables:修改HTTP信息中GET或者POST的參數、值

④:HTTP請求信息的頭部Header

⑤:請求的數據,一般這裏存放的是POST數據

⑥:服務器返回的信息,包含HTTP Header(響應的頭部信息)、Response Data(響應的信息源碼)、View Page:以瀏覽的方式顯示、HTML Structrus Analysis(HTML的結構分析)

Text Only模式:

①:這裏不再熬述,講解SQL盲注功能的時候已經講解了這一條按鈕的作用

②:HTTP的信息,可以自己粘貼進來,也可以對掃描結果進行發送過來,如下:

③:返回響應信息,這裏也不多多說,上面已經詳細說明了。

0×10、AWVS的HTTP嗅探工具(HTTP Sniffer)

作用:設置代理攔截瀏覽器的數據包信息,並且可以將數據包發送到HTTP Edit編輯重放或者其它功能,要想抓取數據包應該將瀏覽器的代理設置爲127.0.0.1:8080(默認),在Application Settings——HTTP Sniffer可以修改監聽的端口和接收的請求範圍。

①:Tools——HTTP Sniffer工具位置

②:Start/Stop:開始或者停止嗅探抓包

Edit Traps: 編輯抓包的規則,例如:攔截ASP、PHP的請求信息、攔截GET請求、攔截POST請求、攔截返回的信息、不攔截images、css、script、顯示PHP報錯信息、替換user-agent等等….

Enable Traps/Disabled Traps:開啓或者關閉規則,如果規則開啓,規則中假如設置了例如Trap ASP and PHP request,嗅探過程中會攔截ASP或者PHP的請求信息並且提示用戶是否修改再發送還是丟棄這個包(有些類似HTTP Edit)。如下:

③:對嗅探到的鏈接進行操作,包括 Edit with HTTP Edit(發送到HTTP Edit進行編輯測試)、Scan to HTTP Fuzzer(發送到HTTP Fuzzer測試)、Start scan form here(從這裏開始掃描漏洞)、 Remove disconnected entries(清空所有的嗅探信息)

⑤:每個嗅探到的鏈接的具體的請求或響應信息

0×11、AWVS的HTTP模糊測試工具(HTTP Fuzzer)

作用:漏洞測試工具,用於批量數據自動提交,並測試出正確性的數據。與Burp中的intruder功能一致。

Request:

①:Tools——HTTP Fuzzer 工具位置

②:Start:開始啓動Fuzzer程序測試 Fuzzer Filters:Fuzzer結果篩選,後面三個圖標分別爲保存爲.fzs的文件、打開爲.fzs的Fuzzer 文件、到處爲XML的Fuzzer結果文件

③:Request:Fuzzer的HTTP數據,可以是自己抓包粘貼上去,也可以通過掃描發送到此處。如上圖的${Gen_2}就代表是攻擊位置使用字典

④:Add Generator:添加一個Fuzzer字典

Insert into Request:插入一個攻擊位置,選中需要被攻擊的位置後點擊此按鈕

Remove Generator:移除Fuuzer字典

Add Generator中包含了六種字典

每個字典的配置如下:

⑥:顯示Fuzzer字典的名字、類型、描述信息

⑦:對Fuzzer字典的設置,參考上方詳解

⑧:Fuzzer字典的簡介

Results:

①:Fuzzer的次數統計

②:Fuzzer的結果顯示,包含下面幾個字段:

#:Fuzzer的次數ID

Status code:返回的響應的狀態

URL:返回的頁面

Generators:提交的參數

Response time:響應花費的時間

Response size:響應內容長度

Word count:單詞數量

③:Request:提交的HTTP請求內容、Response:返回的響應內容、View Page:瀏覽形式查看、Raw Text:文本模式查看

Fuzzer Filters:是針對Fuzzer結果進行篩選的工具

①:選擇一個篩選過濾器

②:分爲5項,分別爲:

Rule description:篩選器的名稱描述

Rule type:篩選器的類型:Include(包含)、Exclude(不包含)、Log

Apply to:關鍵字出現的位置,其中有 Response(所有地方)、Response body(出現在body上)、 Response Header(出現在頭部)、 Response status code(出現在狀態碼上)

Regular expression:輸入正則表達式

③:更新、或者添加一個篩選器

0×12、AWVS的認證測試工具(Authentication Tester)

認證測試工具,用於基本身份認證、簡單的表單認證的破解是從Fuzzer工具中拆分出來的一種。

#1、上圖測試的是HTTP的基本驗證,比如類似Tomcat的/html/manager 驗證

①:Tools——Authentication Tester 工具位置

②:Target URL to test:測試目標 Start:開始Fuzzer

③:Authentication method:認證方式分爲兩種:

HTTP:基本認證

Web from based:簡單的表單認證

④:Logon has failed if:認證失敗的關鍵字分爲三種:

HTTP Status code is :HTTP返回的狀態碼

Results Conditions:返回的結果關鍵字條件

Results match regular expresison:正則表達式匹配

⑤:Username dictionary path:用戶名字典

⑥:Password dictionary path:密碼字典

⑦:正確的結果顯示

#2、表單的形式

表單的形式需要將認證方式改成:Web from based,右側Select選擇,AWVS將自動識別攻擊目標中的表單,如下圖識別出uname、pass兩個字段,選中uname,單擊左下角的“username”,選擇“pass”,單擊左下角的”Password”,這樣表單就可以對應了,加載字典就可以成功Fuzzer了。

0×13、AWVS的WEB WSDL掃描測試工具(Web Services Scanner、Web Services Editor)

作用:掃描WSDL接口漏洞,並且可以對掃描的漏洞進行漏洞測試

WSDL:Web Services Description Language的縮寫,是一個用來描述Web服務和說明如何與Web通信的XML語言。爲用戶提供詳細的接口說明書。WSDL是Web Services的描述語言,是一種接口定義語言,用於描述Web Services的接口信息等。WSDL文檔可以分爲兩部分,頂部由抽象定義組成,而底部由具體描述組成。

Web Services Scanner:

①:Web Services——Weeb Services Scanner

②:掃描的WSDL URL,Profile是側重掃描的類型,默認是ws_default,Start:開始掃描

③: 掃描的結果

Web Services Editor:

①:Web Services——Web Services Editor 工具位置

②:WSDL URL(需要測試的目標URL)、打開圖標(打開一個WSDL目標的文件)、Import(從web services scannner導入)

③:Service(選擇的Service,默認)、Port(協議,分爲ServiceSoap、ServiceSoap12)、Opration(掃描的方法名稱)、Send(發送測試)、HTTP Editor(發送到HTTP Editor測試)

④:Editor:編輯模式 WSDL Structure:WSDL的結構信息 WSDL:目標XML格式的源信息

⑤:Request:方法名稱、參數結構顯示 SOAP:SOAP協議的源,如上我們針對參數username進行了注入測試

⑥:Response:返回XML源信息 Structured Data:返回結果的結構。可以看到已經爆出數據庫版本了

參考文章:

http://www.freebuf.com/tools/43837.html

http://www.acunetix.com/blog/docs/acunetix-wvs-cli-operation/ ;

http://www.acunetix.com/resources/wvsmanual.pdf

轉自: