概述

StatefulSet

RC、Deployment、DaemonSet都是面向無狀態的服務,它們所管理的Pod的IP、名字,啓停順序等都是隨機的,而StatefulSet是什麼?顧名思義,有狀態的集合,管理所有有狀態的服務,比如MySQL、MongoDB集羣等。

StatefulSet本質上是Deployment的一種變體,在v1.9版本中已成爲GA版本,它爲了解決有狀態服務的問題,它所管理的Pod擁有固定的Pod名稱,啓停順序,在StatefulSet中,Pod名字稱爲網絡標識(hostname),還必須要用到共享存儲。

在Deployment中,與之對應的服務是service,而在StatefulSet中與之對應的headless service,headless service,即無頭服務,與service的區別就是它沒有Cluster IP,解析它的名稱時將返回該Headless Service對應的全部Pod的Endpoint列表。

除此之外,StatefulSet在Headless Service的基礎上又爲StatefulSet控制的每個Pod副本創建了一個DNS域名,這個域名的格式爲

$(podname).(headless server name)

FQDN: $(podname).(headless server name).namespace.svc.cluster.localStorageClass

storageclass 是基於pv和pvc的擴展,可以幫助應用程序動態的創建pv和pvc,但是目前還不支持自動擴容。

以部署一個nginx爲例子,Ceph的rbd磁盤爲後端做列子

一.部署一個statefulset應用

rbac配置文件,這裏爲了防止出現權限的問題直接綁定了admin使用

kind: ClusterRoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: rbd-provision

namespace: xuyong-test-storage

subjects:

- kind: ServiceAccount

name: rbd-provisioner

namespace: xuyong-test-storage

roleRef:

kind: ClusterRole

name: cluster-admin

apiGroup: rbac.authorization.k8s.io

---

kind: ServiceAccount

apiVersion: v1

metadata:

name: rbd-provisioner

namespace: xuyong-test-storagestorage-class 配置文件

apiVersion: v1

kind: Secret

metadata:

name: ceph-secret

namespace: xuyong-test-storage

type: kubernetes.io/rbd

#type: kubernetes.io/rbd

data:

key: ................

#上面的key填寫,base64編碼之後的真實的ceph的key,要不然會報錯

---

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: rbd

namespace: xuyong-test-storage

parameters:

##這裏的id填寫ceph的用戶

adminId: kubernetes-online

adminSecretName: ceph-secret

adminSecretNamespace: xuyong-test-storage

imageFormat: "2"

imagefeatures: layering

monitors: saas-ceph.internal.weimob.com:6789

pool: kubernetes-online

userId: kubernetes-online

userSecretName: ceph-secret

userSecretNamespace: xuyong-test-storage

#類型默認

provisioner: kubernetes.io/rbd

reclaimPolicy: Deletestatefulset配置文件

apiVersion: v1

kind: Service

metadata:

name: nginx

namespace: xuyong-test-storage

labels:

app: nginx

spec:

ports:

- port: 80

name: web

clusterIP: None

selector:

app: nginx

---

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: web

namespace: xuyong-test-storage

spec:

selector:

matchLabels:

app: nginx # has to match .spec.template.metadata.labels

serviceName: "nginx" #聲明它屬於哪個Headless Service.

replicas: 3 # by default is 1

template:

metadata:

labels:

app: nginx # has to match .spec.selector.matchLabels

spec:

terminationGracePeriodSeconds: 10

containers:

- name: nginx

image: ccr.ccs.tencentyun.com/weimob-public/nginx:1.16-centos7

ports:

- containerPort: 80

name: web

volumeMounts:

- name: www

mountPath: /usr/share/nginx/html

volumeClaimTemplates: #可看作pvc的模板

- metadata:

name: www

spec:

accessModes: [ "ReadWriteOnce" ]

storageClassName: "rbd" #存儲類名,改爲集羣中已存在的

resources:

requests:

storage: 50Gi注:rbd模式accessModes只支持 ReadWriteOnce和ReadonlyMany,且上面的service必須指定clusterip:none ,要不然會有問題。

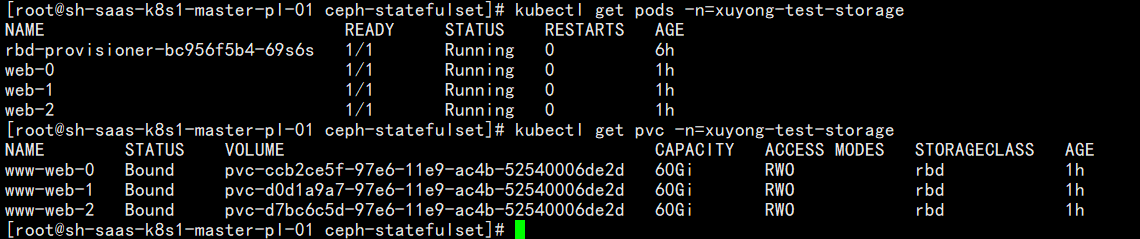

查看效果:

排坑:

1.ecret的key必須base64編碼

2.如果出現rbac問題,執行上面的rbac的文件

3.如果出現cpeh is not in $PATH這樣的報錯,這個是因爲一個鏡像拉不到,可以本地部署,使用本地部署的鏡像,或者***拉鏡像。

4.ceph-common的版本要同你服務器端使用的版本一致。

二.擴容磁盤

參考文檔:https://www.520mwx.com/view/21456

由於statefulset默認不支持磁盤的擴容,所以需要利用ceph的接口來擴容磁盤,實施步驟如下:

1.查看pv對應的rbd image

[root@sh-saas-k8s1-master-pl-01 ceph-statefulset]# kubectl get pv pvc-ccb2ce5f-97e6-11e9-ac4b-52540006de2d -n=xuyong-test-storage -o yaml |grep image

image: kubernetes-dynamic-pvc-ccb7c9b1-97e6-11e9-be31-0a580afb018c

2.直接連接ceph需改rbd塊大小

rbd resize --image kubernetes-dynamic-pvc-ccb7c9b1-97e6-11e9-be31-0a580afb018c --size 100000

3.找到pod所在的node節點,然後重新探測磁盤

blockdev --getsize64 /dev/rbd0

resize2fs /dev/rbd0

4.然後登入pod查看就能發現對應的磁盤大小已經被更改了

注:這個方法可以更改磁盤大小,但是pv和pvc還有storage-class的數據顯示是假的,而且當是多個實例的時候,只能一個個改,比較麻煩。