聲明:

此篇文章,涉及到東西比較多,文章比較長,適合耐心的童鞋們閱讀,生產環境部署可參考此篇文章。

Codis 並不太適合 key 少,但是 value 特別大的應用, 而且你的 key 越少, value 越大,最後就會退化成單個 redis 的模型 (性能還不如 raw redis),所以 Codis 更適合海量 Key, value比較小 (<= 1 MB) 的應用。

codis-proxy 提供連接集羣redis服務的入口

codis-redis-group 實現redis讀寫的水平擴展,高性能

codis-redis 實現redis實例服務,通過codis-ha實現服務的高可用

實驗環境:

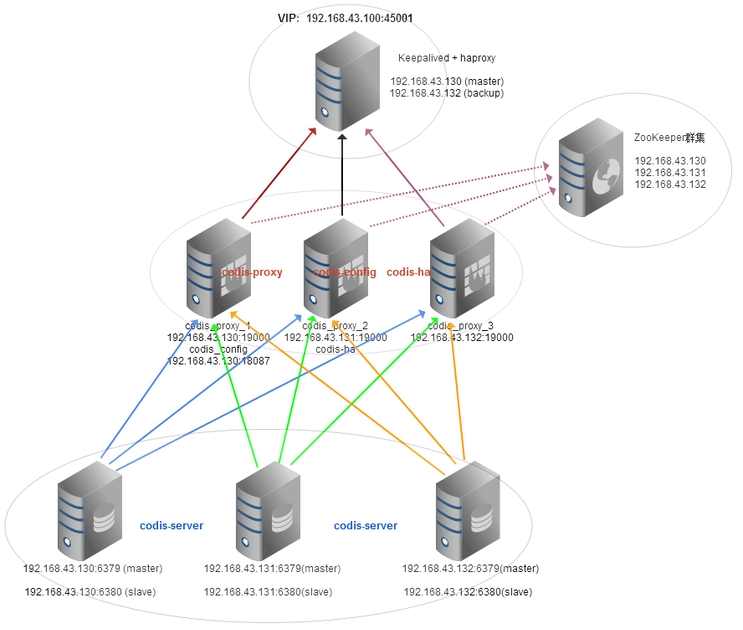

網絡拓撲圖:https://www.gliffy.com/go/publish/4767058

羣集架構圖:https://www.gliffy.com/go/publish/4640202

機器與應用列表:

System version: CentOS 6.5

IP: 192.168.43.130 hostname: vmware-130

apps: keepalived + haproxy Master, zookeeper_1, codis_proxy_1, codis_config, codis_server_master,slave

IP: 192.168.43.131 hostname: vmware-131

apps: zookeeper_2, codis_proxy_2, codis_server_master,slave

IP: 192.168.43.132 hostname: vmware-132

apps: keepalived + haproxy Backup, zookeeper_3, codis_proxy_3, codis_server_master,slave

VIP: 192.168.43.100 Port: 45001

備註:由於是虛擬測試環境,非生產環境,所以一臺機器跑多個應用,如應用於生產環境,只需把應用分開部署到相應機器上即可。

一、初始化CentOS系統

1. 使用鏡像站點配置好的yum安裝源配置文件

cd /etc/yum.repos.d/

/bin/mv CentOS-Base.repo CentOS-Base.repo.bak

wget http://mirrors.163.com/.help/CentOS6-Base-163.repo

接下來執行如下命令,檢測yum是否正常

yum clean all #清空yum緩存

yum makecache #建立yum緩存

然後使用如下命令將系統更新到最新

rpm --import /etc/pki/rpm-gpg/RPM-GPG-KEY* #導入簽名KEY到RPM

yum upgrade -y #更新系統內核到最新

2. 關閉不必要的服務

for sun in `chkconfig --list|grep 3:on|awk '{print $1}'`;do chkconfig --level 3 $sun off;done

for sun in `chkconfig --list|grep 5:on|awk '{print $1}'`;do chkconfig --level 5 $sun off;done

for sun in crond rsyslog sshd network;do chkconfig --level 3 $sun on;done

for sun in crond rsyslog sshd network;do chkconfig --level 5 $sun on;done

3. 安裝依賴包

yum install -y gcc make g++ gcc-c++ automake lrzsz openssl-devel zlib-* bzip2-* readline* zlib-* bzip2-*

4. 創建軟件存放目錄

mkdir /data/packages

5. 軟件包版本以及下載地址:

jdk1.8.0_45

zookeeper-3.4.6

go1.4.2

pcre-8.37

haproxy-1.4.22

keepalived-1.4.26

cd /data/packages

wget http://apache.fayea.com/zookeeper/zookeeper-3.4.6/zookeeper-3.4.6.tar.gz

wget http://golangtc.com/static/go/go1.4.2.linux-amd64.tar.gz

wget ftp://ftp.csx.cam.ac.uk/pub/software/programming/pcre/pcre-8.37.tar.gz

wget http://www.keepalived.org/software/keepalived-1.2.16.tar.gz

通過瀏覽器自行下載:

http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

http://www.haproxy.org/download/1.4/src/haproxy-1.4.26.tar.gz

6. 重啓系統

[root@vmware-130 ~]# init 6

二、部署Zookeeper羣集

1.配置hosts文件 ( zookeeper節點機器上配置 )

[root@vmware-130 ~]# vim /etc/hosts

192.168.43.130 vmware-130

192.168.43.131 vmware-131

192.168.43.132 vmware-132

2.安裝java 壞境 ( zookeeper節點機器上配置 )

[root@vmware-130 ~]# cd /data/packages

[root@vmware-130 packages ]# tar zxvf jdk-8u45-linux-x64.tar.gz -C /usr/local

[root@vmware-130 packages ]# cd /usr/local

[root@vmware-130 local ]# ln -s jdk1.8.0_45 java

3. 安裝Zookeeper ( zookeeper節點機器上配置 )

cd /data/packages

tar zxvf zookeeper-3.4.6.tar.gz -C /usr/local

ln -s zookeeper-3.4.6 zookeeper

cd /usr/local/zookeeper/

4.設置環境變量 ( zookeeper節點機器上配置 )

vim /etc/profile

JAVA_HOME=/usr/local/java

JRE_HOME=$JAVA_HOME/jre

ZOOKEEPER_HOME=/usr/local/zookeeper

JAVA_FONTS=/usr/local/java/jre/lib/fonts

CLASSPATH=$JAVA_HOME/lib:$JAVA_HOME/lib/tools.jar

PATH=$PATH:$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$ZOOKEEPER_HOME/bin

export JAVA_HOME PATH CLASSPATH JRE_HOME ZOOKEEPER_HOME

#生效環境變量

source /etc/profile

5. 修改zookeeper配置文件 ( zookeeper節點機器上配置 )

vi /usr/local/zookeeper/conf/zoo.cfg

tickTime=2000

initLimit=10

syncLimit=5

clientPort=2181

autopurge.snapRetainCount=500

autopurge.purgeInterval=24

dataDir=/data/zookeeper/data

dataLogDir=/data/zookeeper/logs

server.1=192.168.43.130:2888:3888

server.2=192.168.43.131:2888:3888

server.3=192.168.43.132:2888:3888

#創建數據目錄和日誌目錄 ( zookeeper節點機器上配置 )

mkdir -p /data/zookeeper/data

mkdir -p /data/zookeeper/logs

6. 在zookeeper節點機器上創建myid文件,節點對應id

在43.130機器上創建myid,並設置爲1與配置文件zoo.cfg裏面server.1對應。

echo "1" > /data/zookeeper/data/myid

在43.131機器上創建myid,並設置爲1與配置文件zoo.cfg裏面server.2對應。

echo "2" > /data/zookeeper/data/myid

在43.132機器上創建myid,並設置爲1與配置文件zoo.cfg裏面server.3對應。

echo "3" > /data/zookeeper/data/myid

7. 啓動zookeeper服務, 以vmware-130爲例:

[root@vmware-130 ~]# zkServer.sh start

JMX enabled by default

Using config: /usr/local/zookeeper/bin/../conf/zoo.cfg

Starting zookeeper ... STARTED

8.檢查zookeeper所有節點狀態

[root@vmware-130 ~]# zkServer.sh status

JMX enabled by default

Using config: /usr/local/zookeeper/bin/../conf/zoo.cfg

Mode: follower

[root@vmware-131 ~]# zkServer.sh status

JMX enabled by default

Using config: /usr/local/zookeeper/bin/../conf/zoo.cfg

Mode: follower

[root@vmware-132 ~]# zkServer.sh status

JMX enabled by default

Using config: /usr/local/zookeeper/bin/../conf/zoo.cfg

Mode: leader

二、部署Codis羣集

1. 安裝 go 語言環境 ( 所有codis機器上配置 )

/data/packages

tar zxvf go1.4.2.linux-amd64.tar.gz -C /usr/local

2. 添加GO環境變量,其他環境變量不變。

vim /etc/profile

GOROOT=/usr/local/go

GOPATH=/usr/local/codis

PATH=$PATH:$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$ZOOKEEPER_HOME/bin:$GOROOT/bin

export JAVA_HOME PATH CLASSPATH JRE_HOME ZOOKEEPER_HOME GOROOT GOPATH

source /etc/profile

3. 安裝codis ( 所有codis機器上配置 )

yum install -y git

go get github.com/wandoulabs/codis

cd $GOPATH/src/github.com/wandoulabs/codis

#執行編譯測試腳本,編譯go和reids。

./bootstrap.sh

make gotest

# 將編譯好後,把bin目錄和一些腳本複製過去/usr/local/codis目錄下:

mkdir -p /usr/local/codis/{logs,conf,scripts} #創建codis日誌,配置文件,腳本目錄

mkdir -p /data/codis_server/{logs,conf,data} #創建codis_server 日誌,配置文件,數據目錄

cp -rf bin /usr/local/codis/ #複製bin目錄到自定義的安裝目錄

cp sample/config.ini /usr/local/codis/conf/ #複製模板配置文件到安裝目錄

cp sample/redis_conf/6381.conf /data/codis_server/conf/ #複製codis_server配置文件到配置目錄

cp -rf /usr/local/codis/src/github.com/wandoulabs/codis/sample/usage.md /usr/local/codis/scripts/ #複製模板啓動流程文件到腳本目錄下

4. 配置codis_proxy_1 ( vmware-130 機器上配置)

cd /usr/local/codis

vim config.ini

zk=vmware-130:2181,vmware-131:2181,vmware-132:2181

product=codis

proxy_id=codis_proxy_1

net_timeout=5

dashboard_addr=192.168.43.130:18087

coordinator=zookeeper

配置codis_proxy_1 ( vmware-131 機器上配置)

cd /usr/local/codis

vim config.ini

zk=vmware-130:2181,vmware-131:2181,vmware-132:2181

product=codis

proxy_id=codis_proxy_2

net_timeout=5

dashboard_addr=192.168.43.130:18087

coordinator=zookeeper

配置codis_proxy_1 ( vmware-132 機器上配置)

cd /usr/local/codis

vim config.ini

zk=vmware-130:2181,vmware-131:2181,vmware-132:2181

product=codis

proxy_id=codis_proxy_3

net_timeout=5

dashboard_addr=192.168.43.130:18087

coordinator=zookeeper

5. 修改配置文件,啓動codis-server服務. ( 所有codis-server機器上 )

cd /data/codis_server/conf/

mv 6381.conf 6379.conf

vim 6379.conf

修改如下參數: (生產環境,參數適當進行調整)

daemonize yes

pidfile /var/run/redis_6379.pid

port 6379

logfile "/data/codis_server/logs/codis_6379.log"

save 900 1

save 300 10

save 60 10000

dbfilename 6379.rdb

dir /data/codis_server/data

複製6380配置文件

cp 6379.conf 6380.conf

sed -i 's/6379/6380/g' 6380.conf

添加內核參數

echo "vm.overcommit_memory = 1" >> /etc/sysctl.conf

sysctl -p

啓動codis-server服務 ( 所有codis-server機器上 )

/usr/local/codis/bin/codis-server /data/codis_server/conf/6379.conf

/usr/local/codis/bin/codis-server /data/codis_server/conf/6380.conf

6. 查看一下啓動流程:( 以vmware-130機器爲例 )

[root@vmware-130 ~]# cat /usr/local/codis/scripts/usage.md

0. start zookeeper //啓動zookeeper服務

1. change config items in config.ini //修改codis配置文件

2. ./start_dashboard.sh //啓動 dashboard

3. ./start_redis.sh //啓動redis實例

4. ./add_group.sh //添加redis組,一個redis組只能有一個master

5. ./initslot.sh //初始化槽

6. ./start_proxy.sh //啓動codis_proxy

7. ./set_proxy_online.sh //上線proxy項目

8. open browser to http://localhost:18087/admin //訪問管理界面

這只是一個參考,有些順序不是必須的,但啓動dashboard前,必須啓動zookeeper服務,這是必須的,後面有很多操作,都可以在管理頁面完成,例如添加/刪除組、數據分片、添加/刪除redis實例等

7. 創建dashboard啓動腳本。可參考/usr/local/codis/src/github.com/wandoulabs/codis/sample/模板腳本( 只需在一臺機器上啓動即可。43.130上啓動 )

[root@vmware-130 ~]# vim /usr/local/codis/scripts/start_dashboard.sh

#!/bin/sh

CODIS_HOME=/usr/local/codis

nohup $CODIS_HOME/bin/codis-config -c $CODIS_HOME/conf/config.ini -L $CODIS_HOME/logs/dashboard.log dashboard --addr=:18087 --http-log=$CODIS_HOME/logs/requests.log &>/dev/null &

啓動dashboard

[root@vmware-130 ~]# cd /usr/local/codis/scripts/

[root@vmware-130 scripts ]# sh start_dashboard.sh

8. 創建初始化槽腳本,可參考/usr/local/codis/src/github.com/wandoulabs/codis/sample/模板腳本( 在任一臺機器上機器上配置,此環境在43.130機器上配置 )

[root@vmware-130 ~]# vim /usr/local/codis/scripts/initslot.sh

#!/bin/sh

CODIS_HOME=/usr/local/codis

echo "slots initializing..."

$CODIS_HOME/bin/codis-config -c $CODIS_HOME/conf/config.ini slot init -f

echo "done"

執行初始化槽腳本:

[root@vmware-130 ~]# cd /usr/local/codis/scripts

[root@vmware-130 scripts ]# sh initslot.sh

9. 配置codis-server,啓動codis-server master , slave 實例 ,以上步驟已經啓動,不在描述。

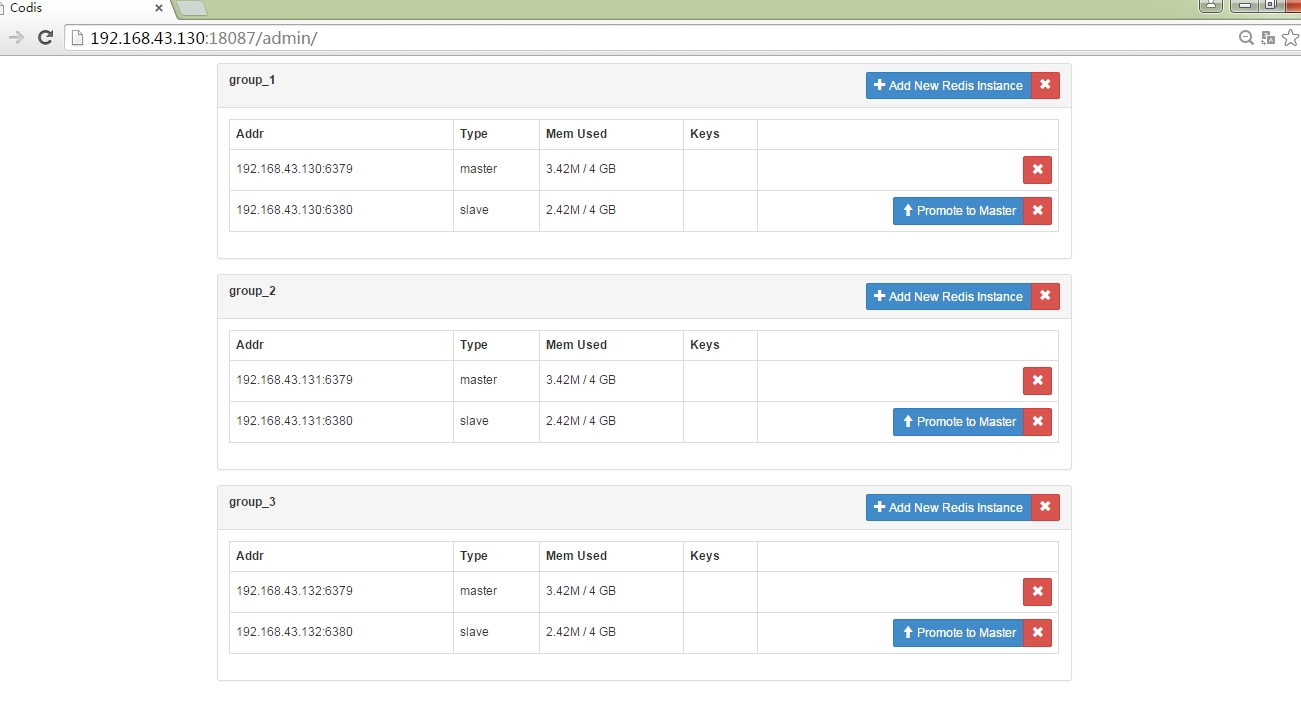

10. 通過管理頁面添加組ID,爲組添加主從實例,一個組裏只能有一個master,設置slot分片數據等。

http://192.168.43.130:18087(最好用Firefox瀏覽器或者谷歌瀏覽器,別的瀏覽器比較坑爹!!!)

如下圖所示:

接下來,依次添加 Server Group 1,2,3 ( 共添加3組 )

添加好後,圖爲下:

接下來添加codis-server實例包括master ,slave

全部添加完成後,如下圖所示:

爲組分配Slot(槽)範圍

group_1 0 - 511

group_2 512 - 1023

group_3 暫時不分配,以下測試中,用來遷移其他組使用。

如下圖操作所示:group_1 ( 0 - 511 )

添加成功後,頁面會顯示success窗口,如下圖所示。

如下圖操作所示:group_2 ( 512 - 1023 )

查看整個Slots分佈情況: 選擇 Slots Status 或者 右上角那個 Slots 都可以看到分佈情況。

11. 配置codis-ha服務,主從自動切換。( 隨便找個節點機器上配置即可,此環境中在43.131機器上配置 )

[root@vmware-131 ~]# go get github.com/ngaut/codis-ha

[root@vmware-131 ~]# cd /usr/local/codis/src/github.com/ngaut

[root@vmware-131 ~]# cp -r codis-ha /usr/local/

[root@vmware-131 ~]# cd /usr/local/codis-ha

[root@vmware-131 codis-ha ]# go build

創建啓動腳本,啓動codis-ha服務

[root@vmware-131 ~]# vim /usr/local/codis-ha/start_codis_ha.sh

#!/bin/sh

./codis-ha --codis-config=192.168.43.130:18087 -log-level="info" --productName=vmware-Codis &> ./logs/codis-ha.log &

創建日誌目錄

[root@vmware-131 ~]# mkdir /usr/local/codis-ha/logs

[root@vmware-131 ~]# cd /usr/local/codis-ha/

[root@vmware-131 codis-ha ]# sh start_codis_ha.sh

12. 修改start_proxy.sh,啓動codis-proxy服務 ( 以130機器配置爲例,其餘codis-proxy只需修改下名稱即可。)

[root@vmware-130 scripts]# vim /usr/local/codis/scripts/start_proxy.sh

#!/bin/sh

CODIS_HOME=/usr/local/codis

echo "shut down codis_proxy_1..."

$CODIS_HOME/bin/codis-config -c $CODIS_HOME/conf/config.ini proxy offline codis_proxy_1

echo "done"

echo "start new codis_proxy_1..."

nohup $CODIS_HOME/bin/codis-proxy --log-level error -c $CODIS_HOME/conf/config.ini -L $CODIS_HOME/logs/codis_proxy_1.log --cpu=8 --addr=0.0.0.0:19000 --http-addr=0.0.0.0:11000 &

echo "done"

echo "sleep 3s"

sleep 3

tail -n 30 $CODIS_HOME/logs/codis_proxy_1.log

[root@vmware-130 scripts]# vim /usr/local/codis/scripts/set_proxy_online.sh

#!/bin/sh

CODIS_HOME=/usr/local/codis

echo "set codis_proxy_1 online"

$CODIS_HOME/bin/codis-config -c $CODIS_HOME/conf/config.ini proxy online codis_proxy_1

echo "done"

啓動codis-proxy

./start_proxy.sh

上線codis_proxy_1

./set_proxy_online.sh

備註:其他codis_proxy只需修改start_proxy.sh和set_proxy_online.sh啓動腳本里面的codis_proxy_1名稱即可。

13. 通過redis-cli客戶端直接訪問codis-proxy,寫入數據,看組裏面的master和slave 是否同步。

[root@vmware-130 scripts]# redis-cli -p 19000

127.0.0.1:19000> set mike liweizhong

OK

127.0.0.1:19000> set benet lwz

OK

127.0.0.1:19000> exit

[root@vmware-130 scripts]#

通過管理界面看到如下圖所示:

codis-server master,slave 同步數據正常,slots槽分片數據正常。

接下來在通過codis-proxy去取數據看看。

[root@vmware-130 scripts]# redis-cli -p 19000

127.0.0.1:19000> get mike

"liweizhong"

127.0.0.1:19000> get benet

"lwz"

127.0.0.1:19000> exit

[root@vmware-130 scripts]#

以下用shell簡單的寫了個插入redis數據腳本,此腳本會插入20W個key,每運行一次,需要調整INSTANCE_NAME參數裏面的數字,纔可重新插入新數據。僅供測試使用:

[root@vmware-132 scripts]# cat redis-key.sh

#!/bin/bash

REDISCLI="redis-cli -h 192.168.43.131 -p 19000 -n 0 SET"

ID=1

while [ $ID -le 50000 ]

do

INSTANCE_NAME="i-2-$ID-VM"

UUID=`cat /proc/sys/kernel/random/uuid`

CREATED=`date "+%Y-%m-%d %H:%M:%S"`

$REDISCLI vm_instance:$ID:instance_name "$INSTANCE_NAME"

$REDISCLI vm_instance:$ID:uuid "$UUID"

$REDISCLI vm_instance:$ID:created "$CREATED"

$REDISCLI vm_instance:$INSTANCE_NAME:id "$ID"

ID=`expr $ID + 1`

done

執行插入腳本

[root@vmware-132 scripts]# sh redis-key.sh

通過管理界面,我們可以看到如下圖所示:

數據插完後,最終如下圖所示:

三、部署Keepalived + haproxy 高可用負載均衡

安裝haproxy、keepalived (43.130、43.132 機器上操作)

1.查看系統內核是否支持 tproxy

[root@vmware-130 ~]# grep TPROXY /boot/config-`uname -r`

CONFIG_NETFILTER_TPROXY=m

CONFIG_NETFILTER_XT_TARGET_TPROXY=m

內核爲2.6.32-220.el6.x86_64,支持TPROXY;

2.源碼安裝pcre-8.01

[root@vmware-130 ~]# rpm -qa|grep pcre

pcre-7.8-6.el6.x86_64

pcre-devel-7.8-6.el6.x86_64

系統已經rpm形式安裝了pcre,但安裝haproxy時,提示找不到pcre的庫文件,看了haproxy的Makefile文件,指定pcre的爲/usr/local下,故再源碼安裝一個pcre-8.01,如下(如果不重新安裝,可以改makefile文件或把庫文件軟鏈到makefile文件指定的路徑)

[root@vmware-130 ~]# cd /data/packages

[root@vmware-130 ~]# tar -zxf pcre-8.37.tar.gz && cd pcre-8.37

[root@vmware-130 pcre-8.36 ]# ./configure --disable-shared --with-pic

[root@vmware-130 pcre-8.36 ]# make && make install

3.安裝 haproxy-1.4.22

[root@vmware-130 ~]# cd /data/packages

[root@vmware-130 ~]# tar xf haproxy-1.4.26.tar.gz

[root@vmware-130 ~]# cd haproxy-1.4.26

[root@vmware-130 haproxy-1.4.26 ]# make TARGET=linux26 CPU=x86_64 USE_STATIC_PCRE=1 USE_LINUX_TPROXY=1

[root@vmware-130 haproxy-1.4.26 ]# make install target=linux26

[root@vmware-130 haproxy-1.4.26 ]# mkdir -p /usr/local/haproxy/sbin

[root@vmware-130 haproxy-1.4.26 ]# mkdir -p /data/haproxy/{conf,run,logs}

[root@vmware-130 haproxy-1.4.26 ]# ln -s /usr/local/sbin/haproxy /usr/local/haproxy/sbin

4. 創建haproxy啓動腳本

[root@vmware-130 ~]# vim /etc/init.d/haproxy

#!/bin/sh

# haproxy

# chkconfig: 35 85 15

# description: HAProxy is a free, very fast and reliable solution \

# offering high availability, load balancing, and \

# proxying for TCP and HTTP-based applications

# processname: haproxy

# config: /data/haproxy/conf/haproxy.cfg

# pidfile: /data/haproxy/run/haproxy.pid

# Source function library.

. /etc/rc.d/init.d/functions

# Source networking configuration.

. /etc/sysconfig/network

# Check that networking is up.

[ "$NETWORKING" = "no" ] && exit 0

config="/data/haproxy/conf/haproxy.cfg"

exec="/usr/local/haproxy/sbin/haproxy"

prog=$(basename $exec)

[ -e /etc/sysconfig/$prog ] && . /etc/sysconfig/$prog

lockfile=/var/lock/subsys/haproxy

check() {

$exec -c -V -f $config

}

start() {

$exec -c -q -f $config

if [ $? -ne 0 ]; then

echo "Errors in configuration file, check with $prog check."

return 1

fi

echo -n $"Starting $prog: "

# start it up here, usually something like "daemon $exec"

daemon $exec -D -f $config -p /data/haproxy/run/$prog.pid

retval=$?

echo

[ $retval -eq 0 ] && touch $lockfile

return $retval

}

stop() {

echo -n $"Stopping $prog: "

# stop it here, often "killproc $prog"

killproc $prog

retval=$?

echo

[ $retval -eq 0 ] && rm -f $lockfile

return $retval

}

restart() {

$exec -c -q -f $config

if [ $? -ne 0 ]; then

echo "Errors in configuration file, check with $prog check."

return 1

fi

stop

start

}

reload() {

$exec -c -q -f $config

if [ $? -ne 0 ]; then

echo "Errors in configuration file, check with $prog check."

return 1

fi

echo -n $"Reloading $prog: "

$exec -D -f $config -p /data/haproxy/run/$prog.pid -sf $(cat /data/haproxy/run/$prog.pid)

retval=$?

echo

return $retval

}

force_reload() {

restart

}

fdr_status() {

status $prog

}

case "$1" in

start|stop|restart|reload)

$1

;;

force-reload)

force_reload

;;

checkconfig)

check

;;

status)

fdr_status

;;

condrestart|try-restart)

[ ! -f $lockfile ] || restart

;;

*)

echo $"Usage: $0 {start|stop|status|checkconfig|restart|try-restart|reload|force-reload}"

exit 2

esac

備註:此腳本stop的時候有問題,有待解決。

#添加haproxy服務

[root@vmware-130 ~]# echo "net.ipv4.ip_nonlocal_bind = 1" >> /etc/rsysctl.conf

[root@vmware-130 ~]# sysctl -p

[root@vmware-130 ~]# chmod 755 /etc/init.d/haproxy

[root@vmware-130 ~]# chkconfig --add haproxy

[root@vmware-130 ~]# chkconfig haproxy on

5.安裝keepalived

[root@vmware-130 ~]# cd /data/packages

[root@vmware-130 ~]# tar zxvf keepalived-1.2.16.tar.gz

[root@vmware-130 ~]# cd keepalived-1.2.16

[root@vmware-130 keepalived-1.2.16 ]# ./configure --with-kernel-dir=/usr/src/kernels/2.6.32-504.16.2.el6.x86_64/

\\若/usr/src/kernels/目錄下爲空,那麼安裝kernel-headers和kernel-devel包 yum install -y kernel-header kernel-devel

[root@vmware-130 keepalived-1.2.16 ]# make && make install

6.配置keepalived,添加keepalived 服務

[root@vmware-130 ~]# cp /usr/local/etc/rc.d/init.d/keepalived /etc/rc.d/init.d/

[root@vmware-130 ~]# cp /usr/local/etc/sysconfig/keepalived /etc/sysconfig/

[root@vmware-130 ~]# mkdir -p /data/keepalived/{conf,scripts}

[root@vmware-130 ~]# cp /usr/local/sbin/keepalived /usr/sbin/

[root@vmware-130 ~]# chkconfig --add keepalived

[root@vmware-130 ~]# chkconfig keepalived on

7. 配置haproxy.cfg配置文件( 43.130, 43.132 配置,haproxy.cfg配置文件完全一樣 )

[root@vmware-130 ~]# vim /usr/local/haproxy/conf/haproxy.cfg

########### 全局配置 #########

global

log 127.0.0.1 local0 err

chroot /usr/local/haproxy

daemon

nbproc 1

group nobody

user nobody

pidfile /usr/local/haproxy/run/haproxy.pid

ulimit-n 65536

#spread-checks 5m

#stats timeout 5m

#stats maxconn 100

######## 默認配置 ############

defaults

mode tcp #默認的模式mode { tcp|http|health },tcp是4層,http是7層,health只會返回OK

retries 3 #兩次連接失敗就認爲是服務器不可用,也可以通過後面設置

option redispatch #當serverId對應的服務器掛掉後,強制定向到其他健康的服務器

option abortonclose #當服務器負載很高的時候,自動結束掉當前隊列處理比較久的鏈接

maxconn 32000 #默認的最大連接數

timeout connect 5000ms #連接超時

timeout client 30000ms #客戶端超時

timeout server 30000ms #服務器超時

#timeout check 2000 #心跳檢測超時

log 127.0.0.1 local3 err #[err warning info debug]

######## proxy 配置#################

listen proxy_status

bind 0.0.0.0:45001

mode tcp

balance roundrobin

server codis_proxy_1 192.168.43.130:19000 weight 1 maxconn 10000 check inter 10s

server codis_proxy_2 192.168.43.131:19000 weight 1 maxconn 10000 check inter 10s

server codis_proxy_3 192.168.43.132:19000 weight 1 maxconn 10000 check inter 10s

######## 統計頁面配置 ########

listen admin_stats

bind 0.0.0.0:8099 #監聽端口

mode http #http的7層模式

option httplog #採用http日誌格式

#log 127.0.0.1 local0 err

maxconn 10

stats refresh 30s #統計頁面自動刷新時間

stats uri /stats #統計頁面url

stats realm XingCloud\ Haproxy #統計頁面密碼框上提示文本

stats auth admin:admin #統計頁面用戶名和密碼設置

stats hide-version #隱藏統計頁面上HAProxy的版本信息

stats admin if TRUE

8. 配置keepalived.conf配置文件 ( 43.130 上配置,43.132備用配置主要修改參數已經標註 )

[root@vmware-130 ~]# vim /data/keepalived/conf/keepalived.conf

! Configuration File for keepalived

global_defs {

notification_email {

[email protected]

}

notification_email_from [email protected]

smtp_connect_timeout 30

smtp_server 127.0.0.1

router_id HAProxy_DEVEL

}

vrrp_script chk_haproxy {

script "killall -0 haproxy"

interval 2

}

vrrp_instance HAProxy_HA {

state BACKUP

interface eth0

virtual_router_id 80

priority 100 #備用爲90

advert_int 2

nopreempt #設置不強佔,防止業務來回切換。

authentication {

auth_type PASS

auth_pass KJj23576hYgu23IP

}

track_interface {

eth0

}

virtual_ipaddress {

192.168.43.100

}

track_script {

chk_haproxy

}

#狀態通知

notify_master "/data/keepalived/scripts/mail_notify.py master"

notify_backup "/data/keepalived/scripts/mail_notify.py backup"

notify_fault "/data/keepalived/scripts/mail_notify.py fault"

}

\\拷貝主上面的keepalived.conf到從上,只需修改priority值參數即可。

創建/data/keepalived/scripts/mail_notify.py郵件通知程序:

詳細請訪問:http://liweizhong.blog.51cto.com/1383716/1639917

\\最後修改下通知信息爲英文,中文內容可能會投遞失敗。

# 配置haproxy日誌

[root@vmware-130 ~]# vim /etc/rsyslog.d/haproxy.conf

$ModLoad imudp

$UDPServerRun 514

local3.* /data/haproxy/logs/haproxy.log

local0.* /data/haproxy/logs/haproxy.log

[root@vmware-130 ~]# vim /etc/sysconfig/rsyslog

SYSLOGD_OPTIONS="-c 2 -r -m 0"

[root@vmware-130 ~]# service rsyslog restart

9. 啓動haproxy、keepalived服務。(先啓動兩個haproxy服務,然後在依次啓動master、backup上的keepalived服務)

[root@vmware-130 ~]# service haproxy start ( 先啓動 haproxy 服務 )

[root@vmware-130 ~]# service keepalived start

10. 測試redis-cli客戶端訪問

[root@vmware-130 ~]# redis-cli -h 192.168.43.130 -p 45001

備註:redis-cli 命令,codis裏面是沒有的,我是安裝redis服務的,只是用codis而已。

到這裏,整個架構已經全部部署完成啦!!!

四、Codis 羣集架構故障測試

備註:由於本環境在本地虛擬機上部署,佔不涉及到性能測試。codis性能測試可使用redis-benchmark工具

1.停止任意zookeeper節點,檢查codis-proxy,dashboard是否正常.

[root@vmware-132 scripts]# zkServer.sh status

JMX enabled by default

Using config: /usr/local/zookeeper/bin/../conf/zoo.cfg

Mode: leader \\目前此節點提供服務

[root@vmware-132 scripts]# zkServer.sh stop \\停止此服務,模擬leader掛掉。

JMX enabled by default

Using config: /usr/local/zookeeper/bin/../conf/zoo.cfg

Stopping zookeeper ... STOPPED

檢查zookeeper其他節點是否重新選取 leader。

[root@vmware-131 ~]# zkServer.sh status

JMX enabled by default

Using config: /usr/local/zookeeper/bin/../conf/zoo.cfg

Mode: leader \\可以看到,vmware-131已經選舉爲leader.

[root@vmware-130 ~]# zkServer.sh status

JMX enabled by default

Using config: /usr/local/zookeeper/bin/../conf/zoo.cfg

Mode: follower

redis客戶端是否能正常訪問到codis-proxy。

[root@vmware-130 logs]# redis-cli -h 192.168.43.100 -p 45001

192.168.43.100:45001> get mike

"liweizhong"

192.168.43.100:45001> get benet

"lwz"

192.168.43.100:45001> get id

"27"

192.168.43.100:45001> exit

[root@vmware-130 logs]#

dashboard管理界面是否正常。

打開瀏覽器,訪問 http://192.168.43.130:18087/admin/

2.停止group master,檢查group slave是否自動切換主

接下來,我們開始來模擬vmware-130機器上的codis-server master 6379端口掛掉

停止codis-master後,檢查codis-ha日誌輸出如下信息:

打開管理界面,查看到如下信息:

客戶端寫入新數據,切換後的主是否有新key增加。

[root@vmware-130 ~]# redis-cli -h 192.168.43.100 -p 45001

192.168.43.100:45001> set abc 123

OK

192.168.43.100:45001> set def 456

OK

192.168.43.100:45001> get abc

"123"

192.168.43.100:45001> get def

"456"

192.168.43.100:45001> exit

打開管理界面,查看到keys增加兩個。

接下來我們恢復vmware-130 codis-server 6379

[root@vmware-130 ~]# /usr/local/codis/bin/codis-server /data/codis_server/conf/6379.conf

[root@vmware-130 ~]# ps -ef |grep codis-server

root 2121 1 0 Apr30 ? 00:02:15 /usr/local/codis/bin/codis-server *:6380

root 7470 1 21 16:58 ? 00:00:00 /usr/local/codis/bin/codis-server *:6379

root 7476 1662 0 16:58 pts/0 00:00:00 grep codis-server

這時,我們在管理界面看到如下情況:

備註:當master掛掉時候,redis-ha檢測到自動將slave切換爲master,但是master恢復後,仍爲offline,需要將其刪除在添加,就可以成爲slave.

按備註那樣,我們需要將原來的master 6379先刪除,然後再次添加。操作完成後,如下圖所示:

3.通過dashboard管理界面添加codis-server組,在線遷移、擴展等。

添加新組,添加master,slave . \\此步省略,之前已經添加好group_3

通過Migrate Slot(s)選項,我們來遷移group_1組到group_3組:

爲了模擬遷移是否會影響到業務,我在一臺機器開啓插入數據腳本,

[root@vmware-132 scripts]# sh redis-key.sh \\腳本里面連接codis羣集請修改爲虛擬IP.

現在又客戶端在實時插入數據,接下來通過管理界面操作步驟如下:

目前客戶端在不斷插入新數據,後端我們又在遷移組數據,那麼我們現在在來get數據看看是否正常。

[root@vmware-130 ~]# redis-cli -h 192.168.43.100 -p 45001

192.168.43.100:45001> get abc

"123"

192.168.43.100:45001> get benet

"lwz"

192.168.43.100:45001> get mike

"liweizhong"

192.168.43.100:45001> get id

"27"

192.168.43.100:45001> exit

可以看到後端在遷移數據,對業務訪問不受影響。這點非常贊。

遷移完成後,如下圖所示:

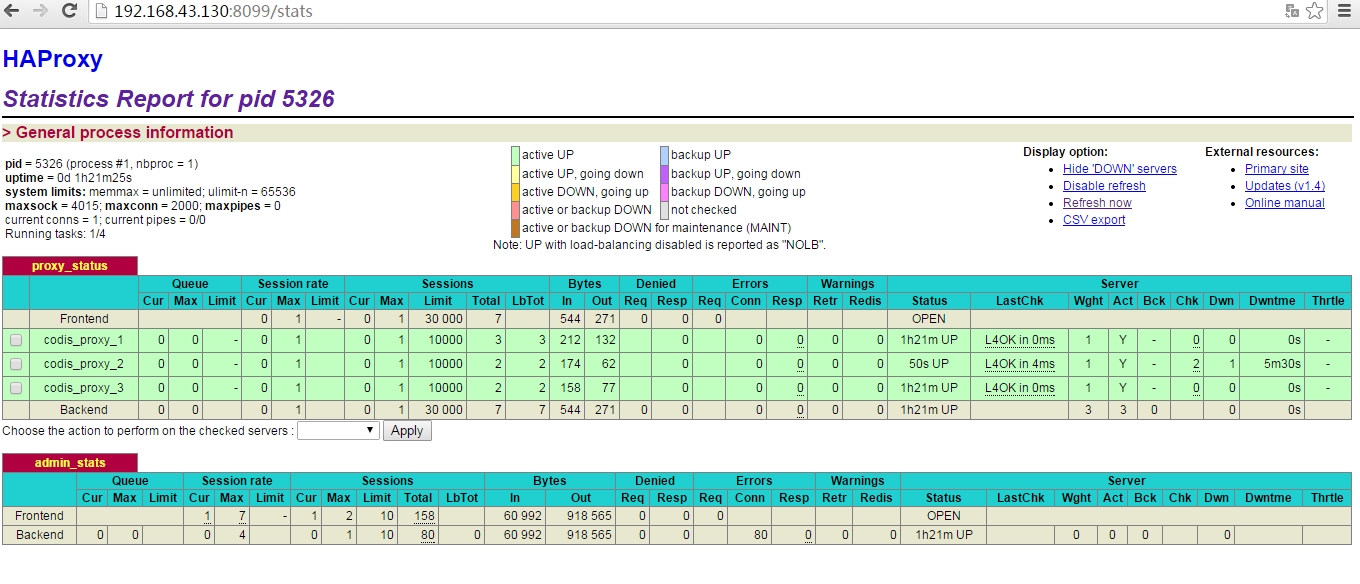

4.模擬codis-proxy節點掛掉,看haproxy服務是否會剔除節點。

我們仍繼續用腳本插入數據,然後停止vmware-131上面的codis-proxy服務。

[root@vmware-132 scripts]# sh redis-key.sh

[root@vmware-130 ~]# redis-cli -h 192.168.43.100 -p 45001

192.168.43.100:45001> get mike

"liweizhong"

192.168.43.100:45001> get benet

"lwz"

192.168.43.100:45001> get id

"27"

192.168.43.100:45001> get abc

"123"

codis-proxy代理節點掛掉一個,haproxy自動剔除此節點,插入數據腳本由於之前連接的socket掛掉,會中斷重新連接新的socket. 業務正常訪問。

以下爲haproxy監控頁面信息:

codis管理界面我們可以看到codis_proxy_2已經沒有顯示出來:

當codis_proxy_2恢復的時候,haproxy又自動加入此節點,並正常提供服務。

codis管理界面又正常顯示codis_proxy_2節點。

5.keepalived+haproxy羣集故障測試

一、停止haproxy-master , 觀察/var/log/message日誌

照樣啓動redis-key.sh插入數據腳本

[root@vmware-132 scripts]# sh redis-key.sh

停止 haproxy master

以下爲截取到的日誌信息:

keepalived master 130 tail -f /var/log/message

keepalived backup 132 tail -f /var/log/message

插入數據腳本會出現中斷,然後又正常插入數據。

虛擬IP出現一次掉包,然後馬上恢復了。

二、恢復haproxy-master, 觀察/var/log/message日誌,看是否被搶佔,正常情況主haproxy恢復後,不會進行切換,防止業務來回切換。。。

接下來我們恢復haproxy-master

[root@vmware-130 logs]# service haproxy start

Starting haproxy: [ OK ]

tail -f /var/log/message

以上截圖我們可以看到恢復haproxy-master後,VIP不會進行漂移,keepalived進入BACKUP狀態,這是因爲設置了nopreempt參數,不搶佔,防止業務來回切換。。。

三、停止haproxy-backup, 觀察 /var/log/message日誌,是否進行切換。

以上我們模擬了haproxy-master故障和恢復,現在我們再次模擬現在的haproxy-master也就是原先的haproxy-backup.

模擬haproxy-backup進程掛掉:

keepalived master 130 tail -f /var/log/message

keepalived backup 132 tail -f /var/log/message

VIP進行了漂移,keepalived也切換身份。

再次恢復haproxy-backup ,VIP不進行漂移,與以上類似,不在描述。

四、模擬keepalived進程掛掉

keepalived-master 掛掉,keepalived主備切換,VIP進行漂移。

當keepalived-master恢復時,直接進入BACKUP狀態,不進行主備切換,VIP不漂移。

參考鏈接:

https://github.com/wandoulabs/codis

https://github.com/wandoulabs/codis/blob/master/doc/tutorial_zh.md

http://0xffff.me/blog/2014/11/11/codis-de-she-ji-yu-shi-xian-part-2/

http://www.cnblogs.com/xuanzhi201111/p/4425194.html

http://blog.csdn.net/freewebsys/article/details/44100919

編寫者: 李惟忠

時 間: 2015-05-01

獻給正打算使用codis架構的童鞋們